あなたのPCが「賢い」プライベート秘書に変わる

要点:NVIDIA AI チャット(ChatRTX)は、GeForce RTXシリーズのGPUを搭載したWindows 11 PCで、大規模言語モデルを直接実行できるツールです。

現在、ChatGPTなどのクラウド型GPTサービスが主流です。

しかし、情報漏洩のリスクを懸念するビジネスパーソンや研究者にとって、ローカルでの生成AI利用は次世代のスタンダードになりつつあります。

NVIDIAが提供するChatRTXは、TensorRT-LLM(※1)というアクセラレーション技術を採用しております。

16GB以上のRAMと8GB以上のVRAMを持つRTX 30/40シリーズがあれば、驚くほど 高速な応答を実現します。

本記事では、2026年の最新トレンドを踏まえ、

- インストール

- プロンプトのコツ

エラーへの対処法まで、私が実際に使って感じた内容を詳細に紹介します。

- ※1 TensorRT-LLM:NVIDIAが開発した、大規模言語モデルの推論をGPUで超高速化するための専用ライブラリ。

NVIDIA AI Chatbotチュートリアル:導入から起動まで

要点:NVIDIA AI チャットを利用するには、ハードウェアの要件を確認しましょう。

公式サイトからexeファイルをダウンロードして、環境構築を行う必要があります。

1. ハードウェア要件 の 最終チェック

2026年現在、NVIDIA AI チャットのポテンシャルを完全に発揮するためには、以下のスペックが推奨されます。

- GPU: GeForce RTX 30シリーズ(Ampere)以降。VRAMは8GBでも動作しますが、16GB搭載の4080や50シリーズ(※14)であれば、回答の生成速度が飛躍的に向上します。

- メモリ (RAM): システム全体で16GB。大規模なPDFデータを検索に含める場合は、32GBあるとマルチタスク時も滑らかです。

- ドライバ バージョン: 535.xx以降。Studioドライバよりも、最新のAI機能が先行して実装されるGame Readyドライバのインストールをおすすめします。

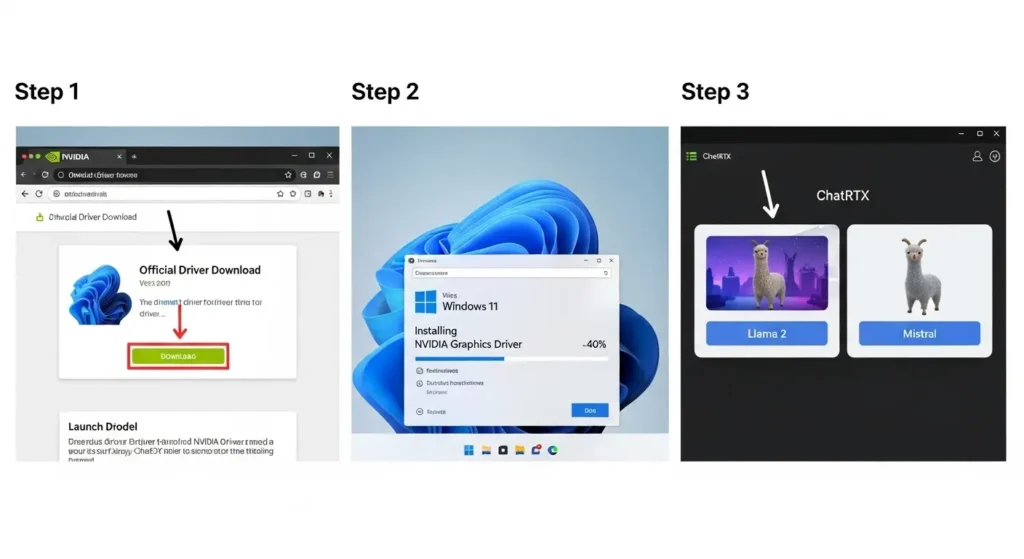

2. インストール プロセス の 詳細

NVIDIAの公式プロダクトページより、ChatRTXのインストーラー(約35MBのランチャー)をダウンロードします。

- 解凍と実行: ダウンロードしたzipファイルをフォルダへ解凍します。setup.exeを右クリックして「管理者として実行」を選択してください。

- モデルの選択: セットアップの途中で、Mistral 7BやLlama 2などのLLM(※15)をどれにするか選択肢が出ます。日本語での対話精度を求めるなら、Gemmaや最新のマルチモーダル対応モデルにチェックを入れましょう。

- ディスク容量の注意: モデルデータの読み込みには、SSD上に40GB以上の空きが必須です。外付けドライブではなく、OSがインストールされた高速な内蔵ドライブへの保存を推奨します。

3. 初回起動と初期設定のポイント

インストールが完了すると、デスクトップにショートカットが作成されます。

- 初回ロード: 最初の起動時は、AIの重みデータをVRAMへ展開(ロード)するため、1〜2分程度の時間がかかります。これは故障ではなく、ローカルでの高速な応答を実現するための準備段階です。

- ファイアウォールの同意: Windowsから「通信を許可しますか」という画面が出る場合があります。これはローカルサーバー(WebUI)をPC内部で構築するために必要な許可です。外部にデータを送信するためのものではないので、安全に「許可」して進めることができます。

- ※12 GeForceドライバ:グラフィックボードを制御するソフトウェア。最新のAI処理命令を含みます。

- ※13 推論:学習済みのAIモデルに新しいデータ(質問)を与え、結果(回答)を導き出すプロセス。

- ※14 50シリーズ:2026年に主流となっているBlackwellアーキテクチャ採用の次世代GPU。

- ※15 LLM:Large Language Model。インターネット上の膨大なテキストを学習した知的な言語モデル。

システム要件と準備

まず、あなたのパソコンのスペックを確認しましょう。

- GPU: NVIDIA GeForce RTX 30または40シリーズ(Ada Lovelace等)。

- VRAM: 最低8GB以上(16GBあればMistral(※2)などの大規模なモデルも滑らかに動作します)。

- OS: Windows 10 / 11。

- RAM: 16GB以上のメインメモリ。

- ストレージ: LLMのウェイト(※3)を保存するため、SSDに35~40GB程度の空き容量が必要です。

インストール手順の注意点

途中でCUDA(※4)ドライバーのアップデートが求められる際は、同意して進めることが重要です。

- ※2 Mistral:フランスのMistral AI社が開発した、軽量ながら高性能なオープンソースの言語モデル。

- ※3 ウェイト:AIモデルの学習済みパラメータ。サイズが大きく、読み込み速度がパフォーマンスに直結します。

- ※4 CUDA:NVIDIAのGPUを汎用計算に使用するための並列コンピューティングプラットフォーム。

NVIDIA AI チャット設定:データセットとの統合

要点:NVIDIA AI チャットの最大の特徴は、RAG(※5)技術を用いて、PC内の

- txt

- docx

- xml

などのファイルをAIに参照させることができる点にあります。

フォルダの指定とファイルの読み込み

アプリを起動すると、画面上に「Dataset」というセクションがあります。

ここでデフォルトの「Folder」を選択します。

解析したいドキュメントが入っているフォルダーを指定します。

更新ボタンをクリックすれば、AIが数秒でインデックス(索引)を作成します。

内容に基づいた質問に答えられるようになります。

言語モデルの選択

ChatRTXでは、Llama 2(※6)や Mistral、Gemma(※7)など、さまざまなモデルを切り替えてテストできます。

日本語の精度を重視するなら、最新のマルチモーダル対応モデルへのアップデートをチェックしてみよう。

2026年現在、GoogleのGemini(※8)技術を一部統合した高性能な選択肢も登場しています。

- ※5 RAG(Retrieval-Augmented Generation):検索拡張生成。外部知識ベースを検索し、その結果をプロンプトに含めて回答を生成する手法。

- ※6 Llama 2:Meta社が公開した大規模言語モデル。非常に人気が高く、標準的に採用されています。

- ※7 Gemma:Googleが公開したオープンな言語モデル。日本語対応も進んでいます。

- ※8 Gemini:Googleの最新かつ最も強力なAIモデルシリーズ。

NVIDIA AIチャットプロンプト:精度を高める書き方

要点:ローカルチャットボットから正確な回答を引き出すには、文脈を指定し、具体的なタスク を与えるプロンプトエンジニアリングが有効です。

具体的な指示の例

単に 「このファイルについて教えて」と聞くのではなく、以下のように書いてみましょう。

「上記のPDFに含まれるプロジェクトのスケジュールを表形式で出力してください。」

このように、出力形式を指定することで、業務効率化に直結する結果が得られます。

文脈(コンテキスト)の活用

NVIDIA AI チャットは、読み込み済みのデータの中から関連する情報を迅速に検索します。

もし期待通りの回答が返ってこない場合は、プロンプトに「ドキュメント内の18ページにある仕様を参照して」と追加することで、推論の精度が向上します。

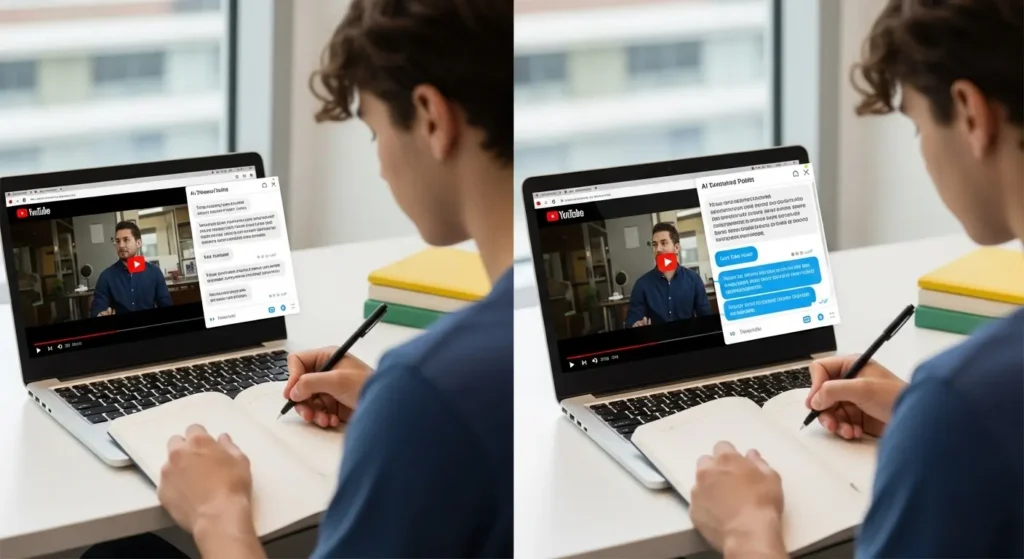

NVIDIA AIチャット活用事例:ビジネスから研究まで

要点:NVIDIA AI チャットの用途は幅広いです。

- 社内文書の探索

- プログラミングのコード解析

- YouTube動画の要約

など、生産性を大幅に高めることが可能です。

ビジネスにおける意思決定支援

大量の調査報告書や市場データをフォルダに入れておけば、市場の動向を即座に抽出できます。

外部サーバーにデータを送信しないため、サイバーセキュリティの観点からも安全です。

クリエイティブと教育への応用

YouTubeのURLを貼り付けることで、動画のトランスクリプト(※9)を取得します。

その内容について対話する機能も人気です。

最新の技術トレンドを学習する学生やエンジニアにとって、これほど強力な学習エージェントは他にありません。

- ※9 トランスクリプト:動画内の音声をテキスト化した書き起こしデータ。

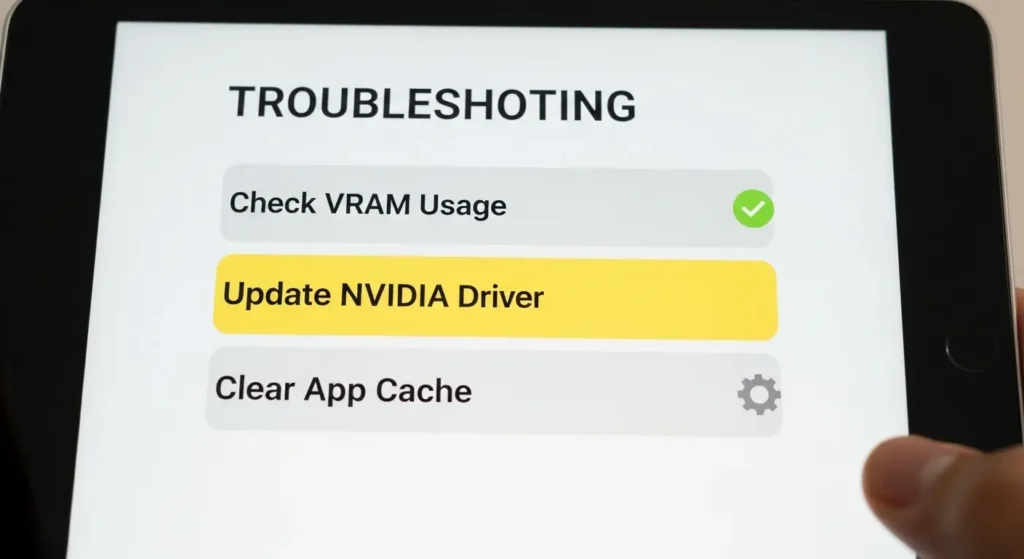

NVIDIA AIチャットエラー:よくある不具合と解決策

要点:起動しない、あるいは回答が遅いといった問題は、VRAM不足やドライバーのバージョン 不整合が主な要因です。

起動時のエラーメッセージ

もし 「not enough VRAM」と表示された場合、バックグラウンドで動作している他のアプリや ゲームを閉じてください。

特に3DレンダリングソフトはVRAMを多く消費します。

モデルの読み込み失敗

レジストリ(※10)のエラーやファイルの破損が疑われる場合は、一度アンインストールします。

フォルダを手動で削除してから再インストールを行います。

NVIDIAの公式フォーラムでは、535.xx以降のGame Readyドライバーを推奨しています。

- ※10 レジストリ:Windowsの設定情報が保存されているデータベース。

よくある質問 (FAQ)

要点:ユーザーから頻繁に寄せられる疑問について、明確な答えをまとめました。

Q1:インターネット接続は必要ですか?

A1:インストール時やモデルのダウンロードにはネットワークが必要ですが、チャット自体は完全にオフラインで動作します。

Q2:日本語での質問に対応していますか?

A2:はい、対応しています。

LlamaやGemmaなどのモデルを選択すれば、日本語での自然な対話が可能です。

2026年のローカルAI時代をリードしよう

要点:NVIDIA AI チャット(ChatRTX)の使い方を習得することは、単なるツールの利用を超え、プライバシーと生産性を両立させるための究極のソリューションを手に入れることと同義です。

現在、AIの進化は加速を続けております。

Blackwell(※11)などの次世代アーキテクチャの登場により、ローカル推論の速度はさらに向上する見込みです。

今回紹介した方法を参考に、今すぐ ChatRTXをセットアップし、自分だけのAI環境を構築して みましょう。

新しいビジネスのインサイトや創作のヒントが、たった数秒のチャットから生まれるかもしれません。

- ※11 Blackwell:2025年末から2026年にかけて市場に投入されるNVIDIAの最新GPUアーキテクチャ。