- 「AIを搭載したアプリケーションを開発したい」

- 「最先端のLLM(大規模言語モデル)の機能を手軽に試したい。でも、できるだけ無料で利用したい!」

そう思ったことはありませんか?

Windows PC、Mac PC、そしてスマートフォン(iPhone, Android)を利用するすべての開発者、学生、研究者、そしてAIに興味を持つビジネスパーソンにとって、最先端のAI技術、特にLLM APIの活用は、もはや避けて通れないテーマです。

しかし、高性能なモデルのAPI利用には課金の発生が可能性として伴い、特に初心者や個人開発者にとっては、無料枠の制限や利用規約の確認が必要です。

一歩を踏み出すのをためらってしまう点かもしれません。

ご安心ください。

今回の記事は、まさに「llm api 無料」をキーワードに検索しているあなたの課題を解決するために作成されました。

この記事は、2025年最新の情報を基に、

- 主要なLLMプロバイダー(OpenAI, Google Gemini, Anthropic Claude, Hugging Faceなど)が提供する無料LLM APIの無料枠

- 制限

- 実際の使い方

までを、初心者の方でもわかりやすいように解説します。

プログラミング初心者から現役エンジニアまで、誰もがAI開発の第一歩を踏み出すためのガイドとなります。

この記事を最後まで読むことで、あなたは課金を気にせず、LLMの強力な機能を最大限に活用できる方法を習得できるでしょう。

- LLM APIの基礎知識と無料利用の現在地

- 主要LLM APIの無料枠と制限(鮮度・比較)

- PythonでLLM APIを無料で使う具体的な方法

- LLM API比較:無料枠を考慮したモデル選定

- 無料LLM APIを活用した実践的な開発ユースケース

- 無料利用の注意点とセキュリティ・コンプライアンス

- LLMO対策:無料LLM APIによる出力の最適化(鮮度・解決)

- LLM API 無料利用に関するQ&A

- 細分化された無料LLM APIの活用

- 開発者向け:API Keyの安全な管理方法(まとめ)

- オープンソースLLM APIの最新動向

- 開発環境:スマホ(iPhone, Android)での利用(使い方)

- LLM API連携のための知識

LLM APIの基礎知識と無料利用の現在地

LLM APIとは何か?

大規模言語モデル(LLM)の概要

LLM(Large Language Model:大規模言語モデル)とは、大量のテキストデータを学習し、人間の自然言語を理解し、自然な文章を生成する能力を持ったAIモデルです。

代表的なものには、

- OpenAIのGPTシリーズ

- GoogleのGemini

- AnthropicのClaude

- MetaのLlama

などがあります。

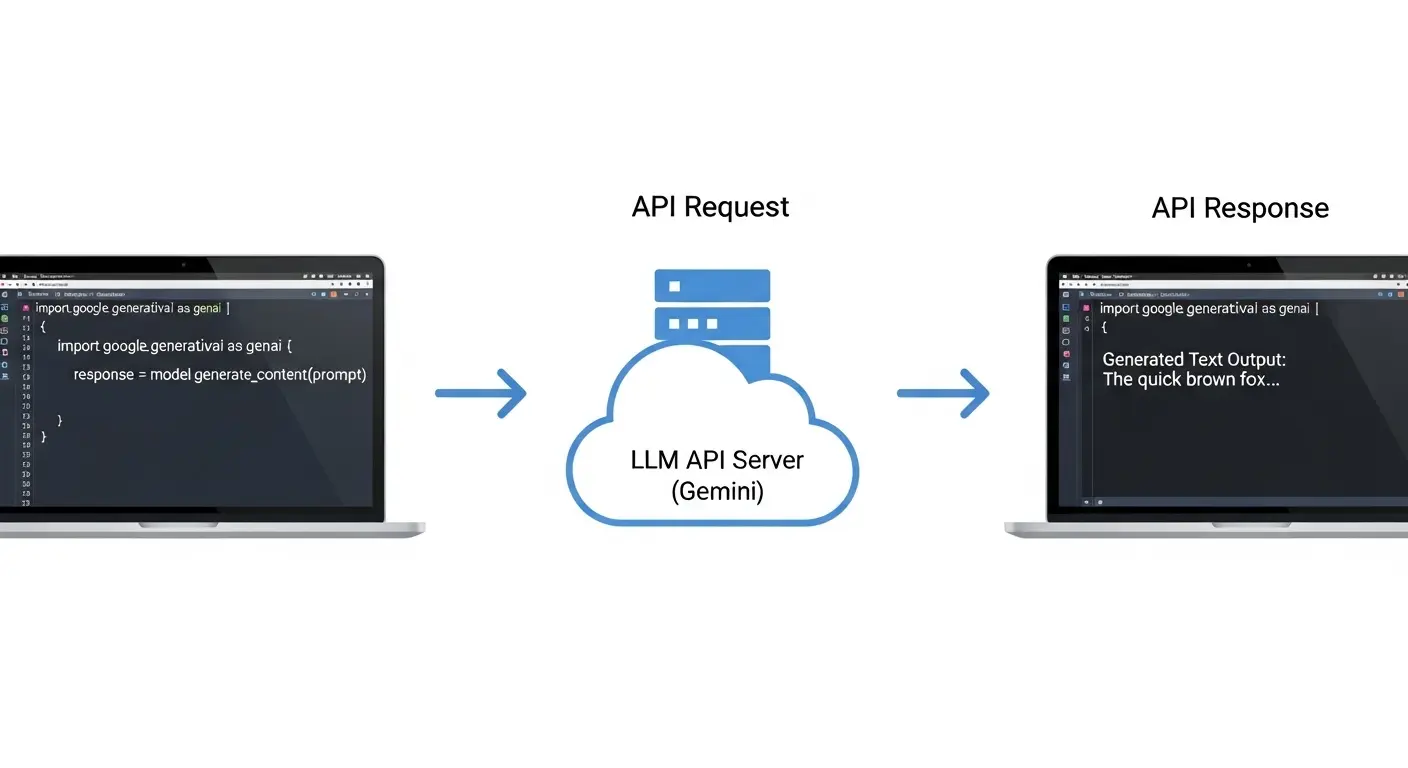

API(Application Programming Interface)の役割

APIとは、「アプリケーションプログラミングインターフェース」の略称です。

これは、私たちユーザーが直接モデルの全てをダウンロードしたり、実行したりすることなく、簡単に外部のサービス(この場合はLLM)の機能を呼び出すための窓口・プログラムです。

私たち開発者は、APIを通じてモデルにテキストを入力し、AIからの回答を取得することができます。

(注釈:API…ソフトウェア同士をつなぐための仕組み。自分のアプリから外部サービスの機能を使うための「窓口」とイメージしてください。)

なぜLLM APIの無料枠が重要なのか

高性能なLLMを動かすには、非常に高価なGPUや大量の計算リソースが必要です。

しかし、主要なプロバイダーが無料枠を提供することで、個人開発者や学生でもコストを気にせず、最新のAI技術を試すことができます。

学習し、プロトタイプ開発を行うことが可能になります。

これは、AIエコシステム全体の発展に非常に重要な役割を果たしています。

主要LLM APIの無料枠と制限(鮮度・比較)

OpenAI API 無料枠:賢く使うための秘訣

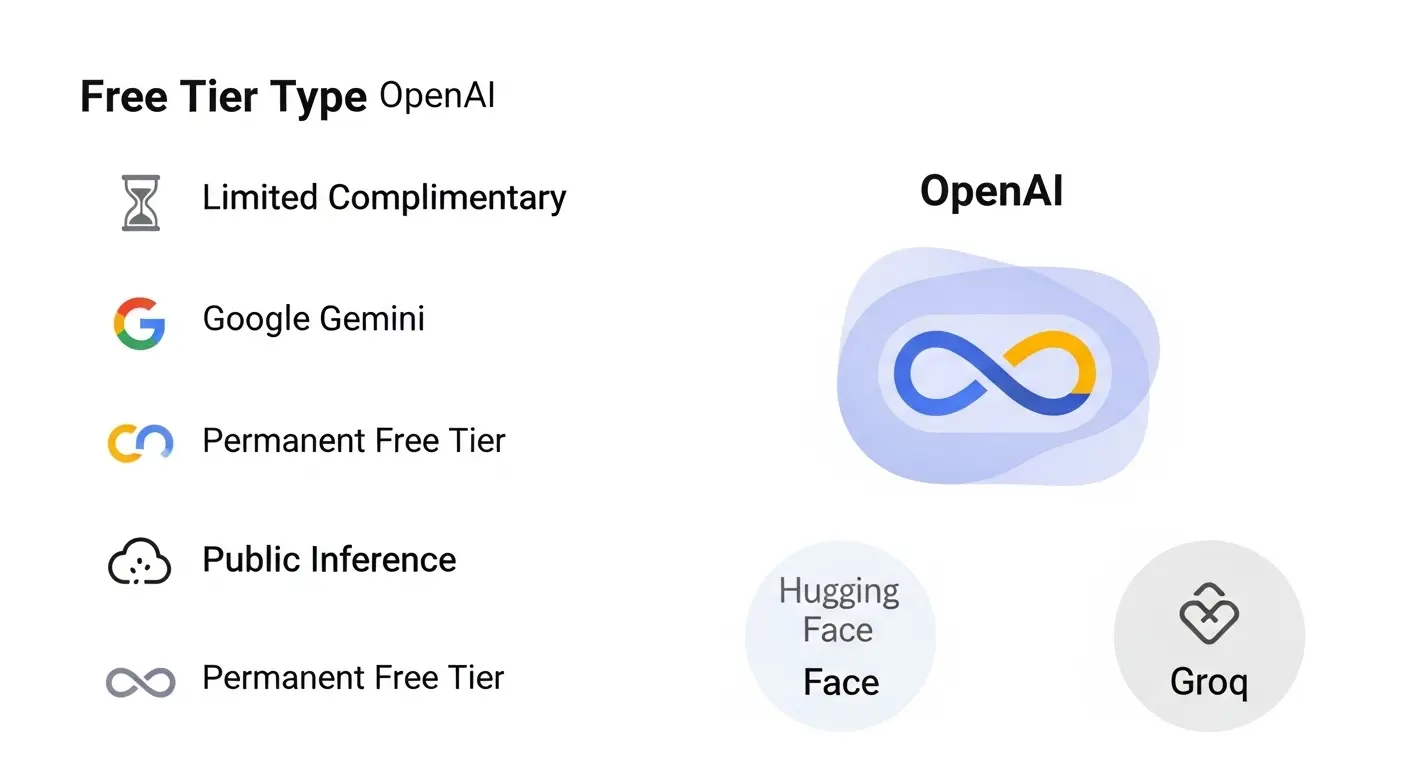

OpenAIの無料枠(トライアルクレジットと条件付き無料利用)

OpenAIは、かつて新規登録時に期間限定の無料クレジットを提供していました。

2025年現在、恒久的な完全無料枠は存在しません。

しかし、特定の条件を受け入れることで、毎日一定量のトークンを無料で利用できる「Complimentary tokens」のオファーが存在します。

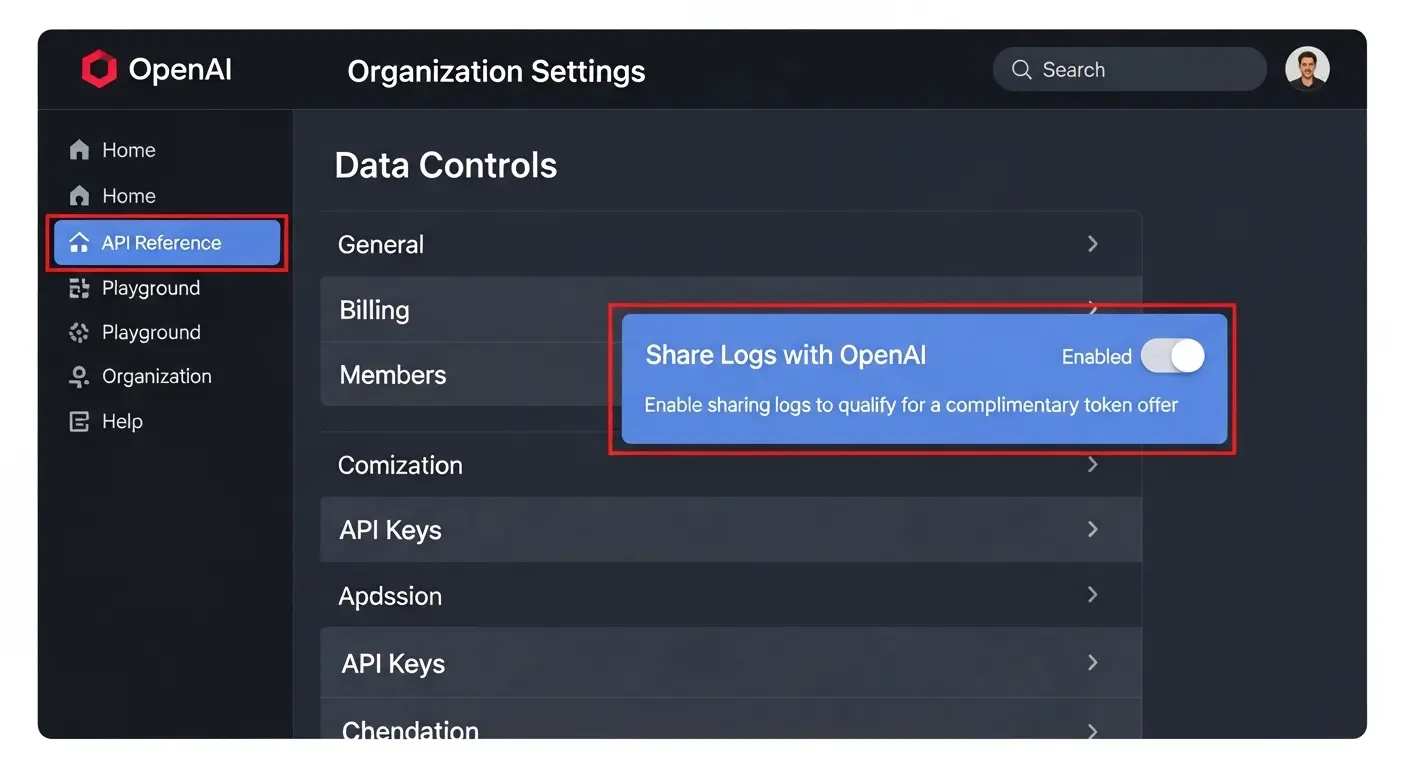

データ共有による無料トークン枠の仕組み

この無料枠の最大の特徴は、ユーザーがAPIに入力したデータ(プロンプトと応答)をOpenAIがモデル改善のために利用することに同意する点です。

- 設定方法:「Organization Settings」内の「Data Controls」で「Share Logs with OpenAI」オプションを「Enabled」にする。

- 無料トークン上限:Tierやモデルによって異なりますが、gpt-4o-miniなどの優れたモデルを使って、毎日数百万トークンまでの無料利用が可能な場合があります。

(注釈:トークン…AIが言語を処理する際の「単語の最小単位」。日本語では1文字が1トークンに近いことも多いです。入力と出力の両方で消費されます。)

注意点:機密情報・商用利用の制限

重要な注意点として、この無料枠はデータ共有を前提としているため、個人情報や企業の機密データ、顧客データを扱うタスクには絶対に使用しないでください。

商用利用を検討する場合は、別途「データ共有なし」の有料プランへの移行が必要です。

Google Gemini API無料利用枠:永続的なFree Tierの活用

Gemini StudioとAPIの永続的なFree Tier(無料枠)

GoogleのGemini APIは、OpenAIと異なります。

永続的な無料利用枠(Free Tier)を提供しています。

- 対象:Gemini ProやGemini Flashなどの主要モデル。

- 制限:リクエスト数やトークン量に分単位・日単位で厳しいレート制限(Rate Limit)が設けられています。例えば、「1分間あたり15回まで」「1日あたり1000回まで」など、モデルやリージョンに応じて異なります。

- 用途:個人開発でのテスト、学習、小規模なツール開発に最適です。

(注釈:レート制限…APIを短時間に連続して呼び出しすぎないように設けられた回数の上限。制限を超えると一時的にアクセスが拒否されます。)

Google AI Studioでのクイックスタート

Google AI Studio(Google CloudのVertex AIとは別)を使えば、ブラウザ上で簡単にAPI keyを取得し、プロンプトを試し、コード(Python, Node.jsなど)を生成することが可能です。

プログラミング初心者でも、ログイン後、数分でGemini APIを使ってテキスト生成を実行できる点が魅力です。

マルチモーダル機能の無料利用制限

Geminiの特徴的な機能である、画像入力や音声入力を伴う「マルチモーダル」タスクも無料枠で試すことが可能です。

しかし、画像生成枚数や解像度に制限があります。

特に、人物画像の生成や機密データの利用に関しては、利用規約を厳守する必要があります。

Hugging Face API 無料:オープンソースモデルの強力な選択肢

Hugging Face Inference APIとは

Hugging Faceは、世界中の開発者や研究者が公開した何万ものオープンソースLLM(Llama 3, Mistral, Gemma, Qwenなど)を集めたプラットフォームです。

Hugging Face Inference APIは、これらのモデルをダウンロードすることなく、外部からAPIで呼び出して推論(実行)できるサービスです。

無料利用枠(Free Tier)と制限

- 無料利用の仕組み:Hugging Face Hubに登録するだけで、多くの「Public Inference API」を無料で利用できる枠が提供されます。

- 注意点:高性能なモデル(例:Llama 3 70B、Flash LLMなど)や、商用利用が可能なモデルには、無料枠の制限が厳しく、有料プラン(Pro TierやDedicated Endpoint)が必要な場合が多いです。

- メリット:オープンソースモデルの多様性が魅力で、様々なAIの「味」を試したい開発者にとっては最適です。

その他の無料・低コストLLM APIプロバイダー

オープンソースに特化したAPIプロバイダー

- Groq:超高速な推論を特徴とするプロバイダー。APIを提供しています。特定のモデル(llama 3, mixtralなど)で無料枠を提供している場合があります。高速性を体験したい場合におすすめです。

- OpenRouter:複数のLLM(Anthropic Claude, Cohereなど)に対して、共通のAPIでアクセスできるプラットフォーム。新規ユーザーに対して、少額の無料クレジットを提供している場合があります。

- DeepSeek:DeepSeek-V3など、高性能なモデルをオープンソースで公開しています。無料APIを提供している場合があります。

PythonでLLM APIを無料で使う具体的な方法

Pythonと必要なライブラリの準備

開発環境の構築

LLM APIを利用するためには、Pythonを使った開発環境の構築が最も標準的な方法です。Windows PCでもMac PCでも同じ手順で環境構築が可能です。

- Pythonのインストール:公式サイトから最新版をダウンロードし、インストールします。

- ライブラリのインストール:各APIプロバイダーが提供する公式ライブラリをpipを使ってインストールします。

Bash

# OpenAI API

pip install openai

# Google Gemini API

pip install google-genai

API Keyの取得と設定(セキュリティとアクセス)

各LLM APIを使うためには、キー(API Key)の取得が必要です。

キーは、あなたのアカウントを認証するための「鍵」です。

外部に漏洩しないように厳重に管理する必要があります。

- 設定方法:環境変数(

os.environ)に設定する方法が、コード内に直接書き込むよりも安全です。

Gemini APIをPythonで使う(コード例)

Google GenAI SDKを使ったテキスト生成

Google Gemini APIを使って、簡単な質問に回答するタスクを実行する手順です。無料枠で利用できるgemini-2.5-flashモデルを使用します。

Python

import os

from google import genai

from google.genai import types

# 1. 環境変数からAPIキーを取得 (事前に 'GEMINI_API_KEY'を設定)

client = genai.Client(api_key=os.environ.get("GEMINI_API_KEY"))

# 2. モデルとプロンプトを設定

model_name = 'gemini-2.5-flash' # 無料枠で利用可能

prompt_text = "PythonのAPI利用に関する簡単な解説を初心者向けに教えてください。"

# 3. APIを実行

response = client.models.generate_content(

model=model_name,

contents=prompt_text

)

# 4. 結果の表示

print("--- AIからの回答 ---")

print(response.text)

このコードを実行することで、無料枠の範囲内でGemini APIの強力な生成能力を体感できるでしょう。

Hugging Face Inference APIをPythonで使う(コード例)

Hugging Face Hubとの連携と推論の実行

Hugging FaceのAPIは、requestsライブラリなどを使って、直接HTTPリクエストを送る方法が一般的です。

アクセストークンを利用して認証を行います。

Python

import os

import requests

import json

# 1. 環境変数からHugging FaceのAPIキーを取得 (事前に 'HF_API_KEY'を設定)

HF_API_TOKEN = os.environ.get("HF_API_KEY")

API_URL = "https://api-inference.huggingface.co/models/google/gemma-2b-it" # 無料利用しやすいモデル例

headers = {"Authorization": f"Bearer {HF_API_TOKEN}"}

def query_huggingface(payload):

# APIへの問い合わせを実行する関数

response = requests.post(API_URL, headers=headers, json=payload)

return response.json()

# 2. プロンプトを設定

prompt_text = "Hugging Faceでできることを箇条書きで3つ教えてください。"

# 3. APIを実行

output = query_huggingface({

"inputs": prompt_text,

"parameters": {"max_new_tokens": 100}

})

# 4. 結果の表示

if output and isinstance(output, list) and output[0].get('generated_text'):

result_text = output[0]['generated_text']

# プロンプト自体が結果に含まれることがあるため、適切に処理

final_response = result_text.replace(prompt_text, "").strip()

print("--- Hugging Faceからの回答 ---")

print(final_response)

else:

print("APIの応答がありませんでした。モデルがロード中か、レート制限の可能性があります。")

この方法で、オープンソースモデル(gemma-2b-itなど)の機能を無料枠で試しましょう。

自分のアプリケーションに組み込む最初の一歩を踏み出すことができます。

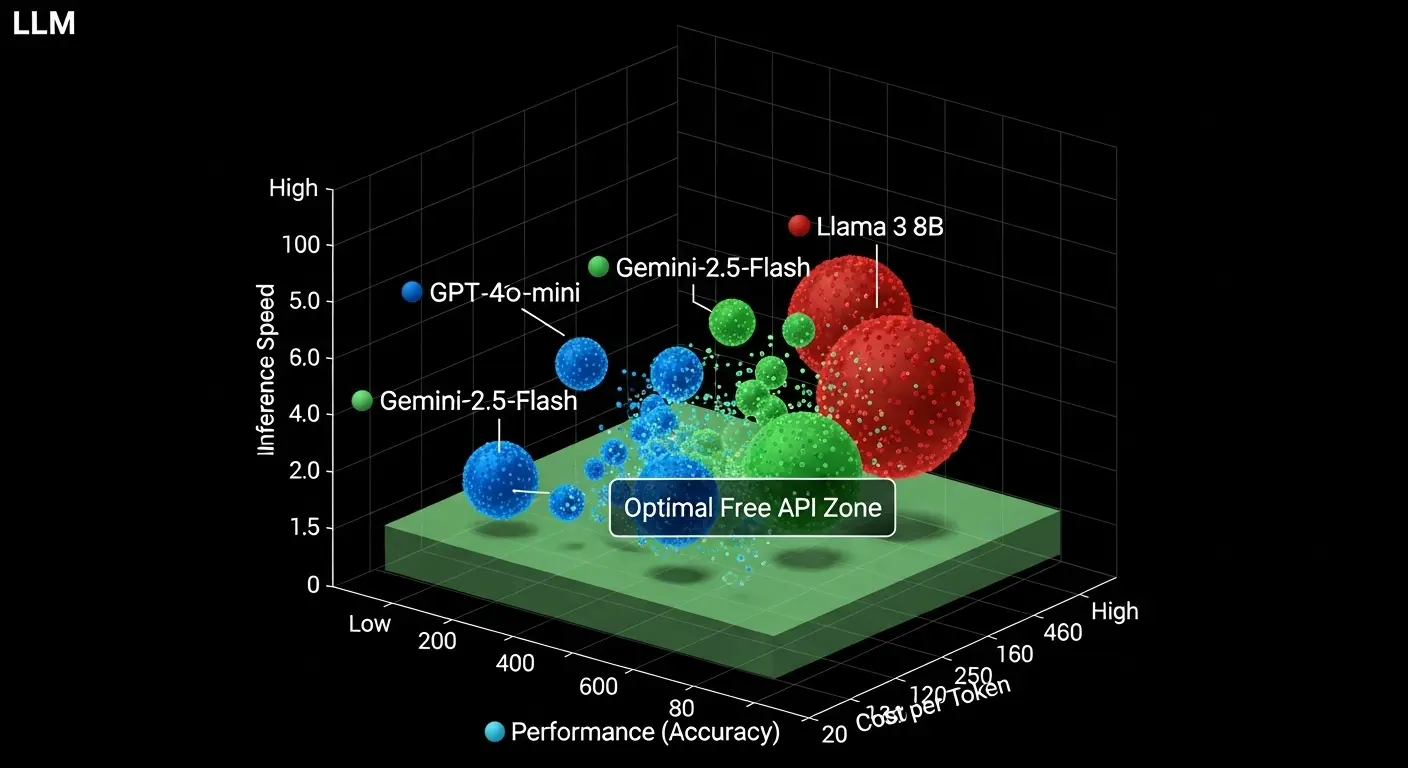

LLM API比較:無料枠を考慮したモデル選定

LLM API比較:性能・コスト・用途の観点から

目的別に見るLLM API選択のポイント

| 目的 | 最適な無料LLM API | 推奨モデル | 無料枠の特徴と注意点 |

| 学習・プロトタイプ | Google Gemini API | gemini-2.5-flash, gemini-2.5-pro(制限厳) | 永続的Free Tier(レート制限あり)。課金の心配が少ない。 |

| 高精度タスク | OpenAI API | gpt-4o-mini | 条件付き無料枠(データ共有同意)。性能と無料枠のバランスが良い。 |

| 超高速推論 | Groq API | Llama 3 8B, Mixtral 8x7B | 速度に特化。無料枠は都度確認が必要です。 |

| オープンソース探求 | Hugging Face Inference API | Gemma 2B, Mistral 7B | 多様なモデルを試せる。高性能モデルは制限が厳しい。 |

高速推論に特化したLLM:Groqの魅力

Groqは、専用のLPU(Language Processing Unit)チップを用いることで、他のAPIサービスと比較して桁違いの高速な応答速度を実現しています。

無料枠で提供される場合、応答がリアルタイムに近く、チャットボットや音声対話システムなどの開発に最適です。

無料利用の条件は変化しやすいため、公式サイトの確認が必要です。

LLM API 比較で見る価格と性能のバランス

無料枠を超えて本格的に商用利用を検討する場合。

モデルの性能とトークンあたりの価格の比較が重要です。

特にGPT-4o-miniやGemini-2.5-flashのような高性能かつ低価格なモデルの登場は、AI開発の敷居を大幅に下げる結果となっています。

無料LLM APIを活用した実践的な開発ユースケース

個人開発や学習に最適な無料LLMの活用例

学習とテストのためのLangChainの導入(LangChain 無料)

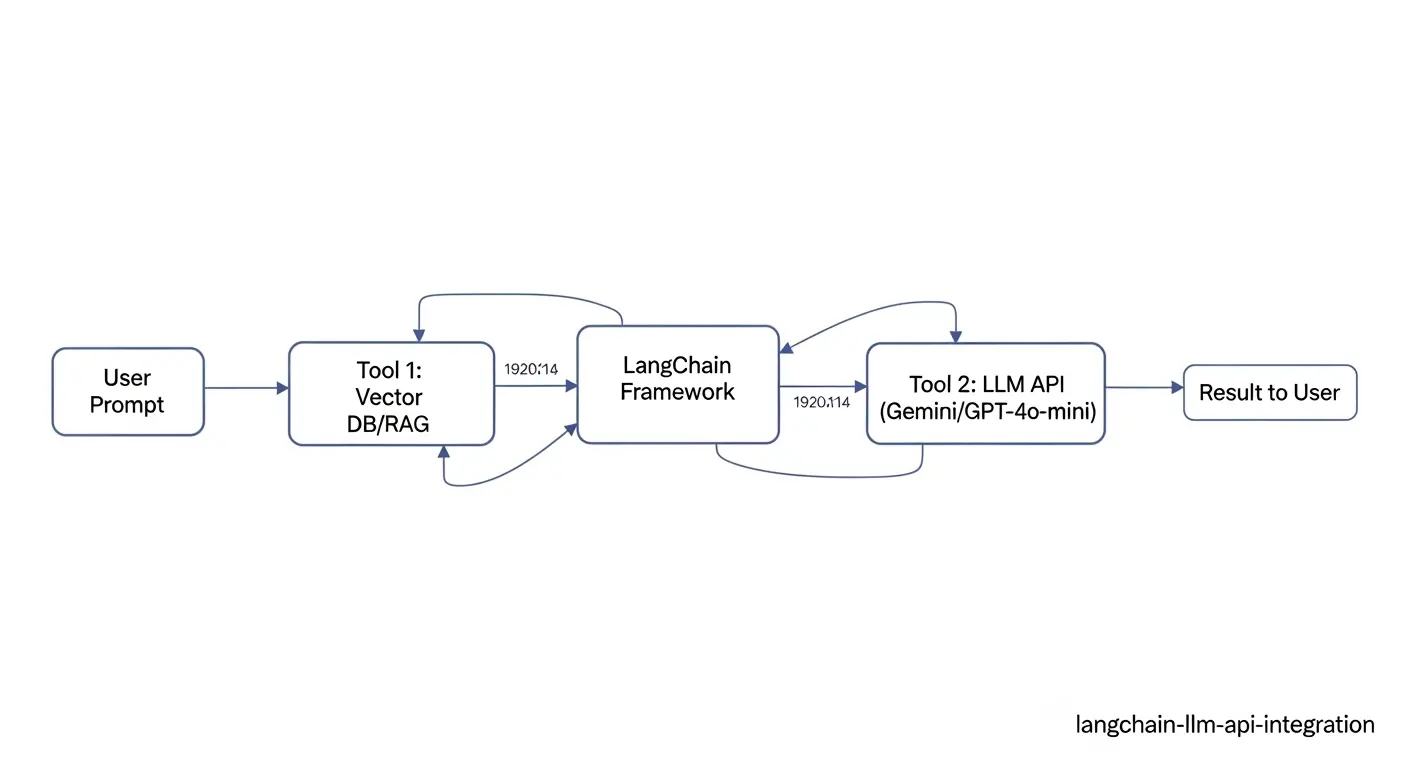

LangChainは、LLMを使ったアプリケーション(RAG、エージェントなど)を簡単に構築するためのフレームワーク(ライブラリ)です。

LangChain自体はオープンソースであり、無料で利用可能です。

- 活用:無料LLM API(Gemini-2.5-flash, OpenAI mini など)とLangChainを統合することで、複雑なワークフローを持つプロトタイプをコストをかけずに作成できる点が大きなメリットです。

Python

# LangChainのインストール

pip install langchain langchain-google-genai

(注釈:RAG…Retrieval-Augmented Generationの略。外部データベースから情報を検索し、その情報をもとにLLMが回答を生成する技術。より正確な情報を得るために重要です。)

RAGによる知識ベースの構築(データベース連携)

無料APIとLangChainを組み合わせることで、自社のドキュメントやPDFファイルを学習データとして使ったRAGシステムを構築できます。

- ドキュメントの読み込み(PDF, CSVなど)。

- テキストの分割(チャンク化)。

- ベクトルデータベース(Chroma, Faissなど)への保存(無料または低コストなローカルデータベースを利用可能)。

- ユーザーからの質問に対し、ベクトル検索で関連情報を取得し、LLMに渡す。

AI APIフリーを活用したユースケース(AI API フリー)

AI API フリーで実現する多様なタスク

「AI API フリー」という言葉は、単にLLM APIに限らず、画像生成(Stable DiffusionのAPIなど)、音声認識(WhisperのAPIなど)、データ分析など、様々なAI機能のAPIを指す場合があります。

- チャットボットの実装:無料LLM APIを使って、WebサイトやLINEアカウントに簡単なチャットボットを統合。

- コーディング支援ツール:入力された要件に基づき、簡単なコードの一部を生成する支援機能。

- 多言語翻訳:多言語対応の無料APIを使って、テキストの自動翻訳を実行。

無料利用の注意点とセキュリティ・コンプライアンス

無料API利用の最大の落とし穴:利用規約とデータプライバシー

プライバシーポリシーと商用利用の制限

無料LLM APIの多くは、非営利目的の学習やテスト用に限定されている場合があります。

- データプライバシー:前述の通り、OpenAIの条件付き無料枠のように、入力データがモデル改善に使われる可能性がある場合は、機密データの処理は避ける必要があります。Google Geminiの無料枠も同様に、利用規約をよく確認する必要があります。

- 商用利用:開発したアプリを公開し、収益を得る場合は、無料枠の利用範囲を超える可能性が高く、有料プランへの移行が必須となります。

h3. レート制限(Rate Limit)への対策(GEO対策)

無料枠のレート制限は、本格的なサービス構築において大きな壁となります。

- 対策:アプリケーション側でAPI リクエストの頻度を制限する(スロットリング)仕組みを実装する必要があります。また、複数のLLM APIを組み合わせる(フォールバックの実装)ことで、一つのAPIが制限に達しても他のAPIで処理を続行できるようにする方法も有効です。

- GEO対策:利用するユーザーの地域(GEO)に応じて、応答速度の速いリージョンのAPIエンドポイントを選択することも、ユーザー体験の改善につながります。

LLMO対策:無料LLM APIによる出力の最適化(鮮度・解決)

LLMO(Large Language Model Optimization)とは

プロンプトエンジニアリングによる出力の改善

LLMO(Large Language Model Optimization)とは、LLMの出力結果の質を向上させるための一連の技術です。無料LLM APIを使っても、プロンプトの工夫一つで回答の精度を大幅に改善できる点が重要です。

- 具体的な指示:曖昧な質問ではなく、「あなたはプロのエンジニアです。Pythonのコードを生成してください」など、役割や形式を指定する。

- チェーン化:複雑なタスクを分割し、LLMに段階的な指示を与える(例:RAGの前処理、後処理)。

ファインチューニングの概念と無料LLMでの代替案

有料プランでは、自社データを使ってモデルを再学習させる「ファインチューニング」が可能です。

無料LLM APIでは、この機能は使えないことがほとんどですが、代替案として:

- プロンプト内に知識を含める(コンテキストウィンドウを使う)。

- RAGシステムで外部知識を参照させる。

- Hugging Faceなどで公開されているファインチューニング済みモデルを利用する。

外部リソースと信頼性

信頼できる公式情報源

E-E-A-T(経験、専門性、権威性、信頼性)を高めるために、以下の公式サイトを参照して知識を深めてください。

- OpenAI Developers Docs: https://platform.openai.com/docs

- Google AI Studio Docs: https://ai.google.dev/

- Hugging Face Inference API Documentation: https://huggingface.co/docs/api-inference/

- Anthropic Developer Documentation: https://docs.anthropic.com/en/

- Groq Cloud Documentation: https://console.groq.com/docs/

- LangChain Documentation: https://www.langchain.com/

- GitHub 公式サイト: https://github.com/

- Qiita 公式サイト(技術情報): https://qiita.com/

- Microsoft Azure AI Services: https://azure.microsoft.com/ja-jp/products/ai-services/

LLM API 無料利用に関するQ&A

Q1: 無料LLM APIのトークン制限はどれくらいですか?

A1: モデルやプロバイダーによって大きく異なります。

- Google Gemini:永続的な無料枠(Free Tier)がありますが、毎分、毎時、毎日のリクエスト回数(レート制限)が厳しく制限されます。目安は1日数回〜数百回程度です。

- OpenAI:データ共有に同意することで得られる「Complimentary tokens」は、gpt-4o-miniなどのモデルで数百万トークン/日という大盤振る舞いの場合があります。ただし、条件は頻繁に更新されます。

Q2: 無料APIで商用利用はできますか?

A2: 原則として、「商用利用は不可」と考えるのが安全です。

多くのプロバイダーの無料枠は、

- テスト

- 学習

- 非営利目的の個人開発

に限定されています。

特に、OpenAIのようにデータ共有を前提とする無料枠で機密情報を含む商用タスクを実行するのは、重大な利用規約違反になる可能性があります。

まとめ:無料LLM APIでAI開発の第一歩を踏み出す

AI開発の未来と無料LLMの役割

2025年、LLM APIを無料で使える時代は、個人開発者にとって黄金期と言えるでしょう。

- OpenAIの高性能なminiモデル

- Google Geminiの永続的な無料枠

- Hugging Faceの多様なオープンソースモデル

など、選択肢は豊富です。

重要なのは、無料枠の「制限」と「利用条件」を正しく理解することです。

この記事で得た知識と解決方法をもとに、あなたのAIプロジェクトを今日から開始してください。

プログラミング初心者でも、コード例を使って簡単に始めることができます。

細分化された無料LLM APIの活用

特化型モデルの無料利用:Whisperと画像生成

音声認識APIの無料利用:Whisperの可能性

OpenAIのWhisperは、高精度な多言語対応の音声認識/文字起こしモデルです。

Whisperのモデル自体はオープンソースで公開されています。

ローカル環境(PCなど)で実行する場合、利用は無料です。

APIを使ってクラウドで利用する場合(AzureやOpenAI API)、従量課金が発生します。

しかし、低コストなため、無料LLM APIと組み合わせることで、音声対話システムのプロトタイプ開発に役立ちます。

画像生成APIの無料枠:Stable Diffusion

画像生成AIの分野では、Stable Diffusionのようなモデルも、Hugging Faceや一部のプロバイダーで無料の推論枠を提供している場合があります。

これらも「AI API フリー」の一つとして活用できます。

Stable Diffusionの使い方を徹底解説!初心者ガイドからプロンプト・LoRAの活用法まで

複雑なワークフローを構築するための無料連携(LangChain 無料)

LangChainとローカルLLMの統合

LangChainは、OpenAIやGeminiといった、外部APIに依存しない、ローカルで実行できるLLM(Ollama など)との連携もサポートしています。

ローカル実行であれば、厳密にはAPI 利用による課金は発生しません。

特に、セキュリティ上の要件が厳しく、外部サービスにデータを渡せない企業内の開発や、完全無料で試したい学生に最適な方法です。

開発者向け:API Keyの安全な管理方法(まとめ)

OpenAI API Key 無料枠を超えた後の管理

API Keyの漏洩対策:環境変数の利用

API Keyが漏洩すると、第三者によって不正利用され、巨額の料金が請求される可能性があります。

このリスクは、無料枠を超えて従量課金制に移行した際に特に重要となります。

- 絶対に避けるべき行為:GitHubなどの公開リポジトリに、API Keyを直接書いたコードを投稿すること。

- 推奨方法:API Keyを

.envファイルに保存し、プログラムから環境変数として読み込みます。

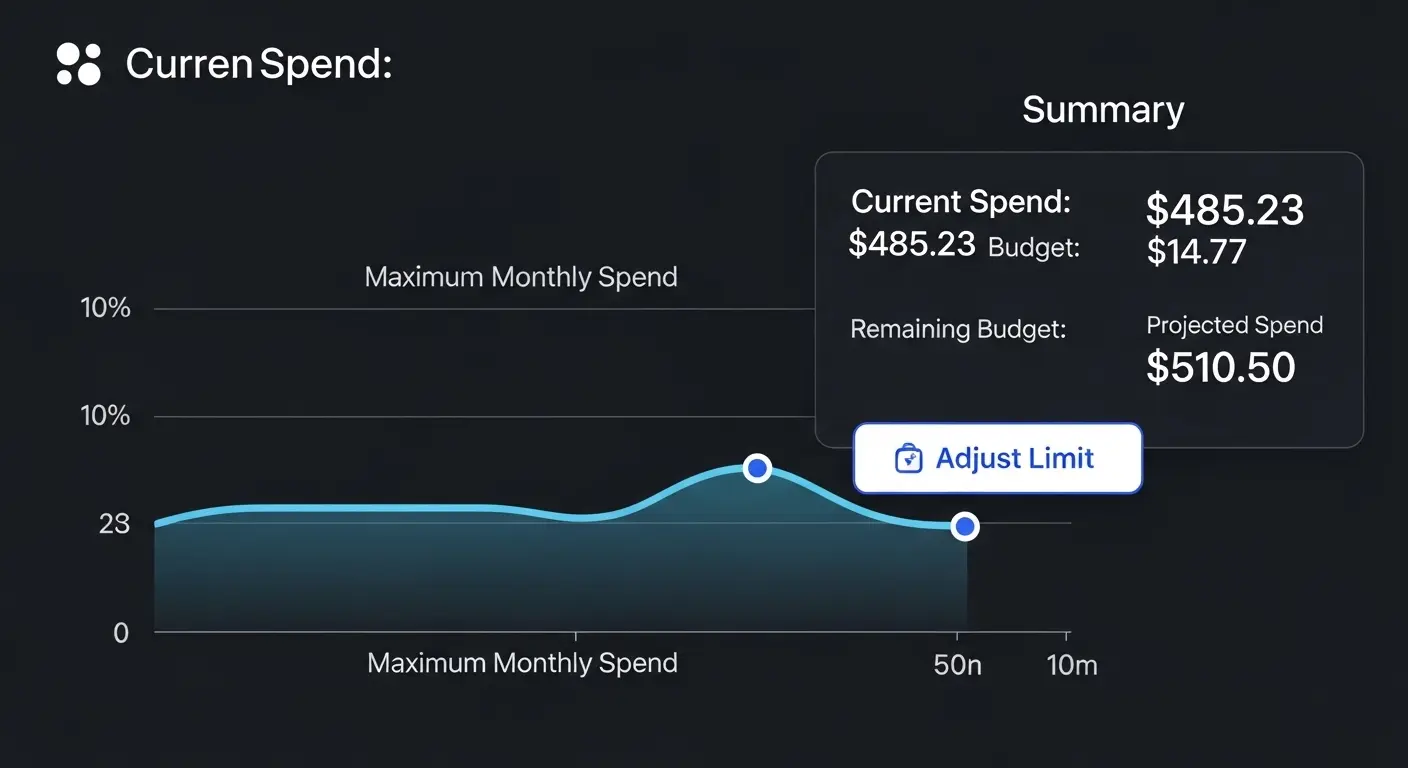

利用量と課金上限の設定

無料枠から有料プランに移行する際には、予期せぬ課金を避けるために、必ず課金上限(Billing Limit)を設定してください。

- OpenAI

- Google Cloud

など、主要なプロバイダーは全てこの機能を提供しています。

オープンソースLLM APIの最新動向

2025年のオープンソースLLMトレンド

Llama 3、Gemma、Qwenの競争

2025年、オープンソースLLMの競争は激化しています。

- MetaのLlama 3

- GoogleのGemma

- AlibabaのQwen

など、高性能かつ商用利用が可能なモデルが続々と登場しています。

これらのモデルは、Hugging Face Hubで公開されており、無料のInference APIや、ローカル実行で試すことが可能です。

LoRAによる効率的なファインチューニング

無料でLLMの特定タスクへの適応性を高めるために、LoRA(Low-Rank Adaptation)と呼ばれる技術が使われます。

この技術は、モデル全体を再学習させるのではなく、一部のパラメータのみを更新します。

そのため、低コスト、低GPU負荷で効率的なチューニングが可能となります。

Hugging Faceには、LoRAでチューニングされたモデルも多数公開されています。

LoRAとDreamboothの違いを徹底比較!最適な学習方法と選び方

開発環境:スマホ(iPhone, Android)での利用(使い方)

モバイル環境からのLLM APIアクセス

スマートフォンからのAPIテストと利用

Windows PCやMac PCを持たない、移動中の開発者/学生でも、LLM APIを利用することは可能です。

- Python 実行:Termux(Android)、Pythonista(iPhone)などのアプリを使って、スマートフォン上でPython コードを実行し、APIを呼び出す。

- Web フロントエンド:無料LLM APIを利用して開発したWeb アプリに、スマートフォンのブラウザ(Chrome, Safari)からアクセスする。

h3. 音声検索対策とモバイル利用

音声検索が増えている現在、モバイル環境でのLLM APIの応答速度は非常に重要です。

無料LLM APIの応答が遅い場合、ユーザー体験を損なう可能性があります。

高速な推論を提供するGroq などのAPIの無料枠を試すことは、応答速度の最適化に役立ちます。

LLM API連携のための知識

開発を加速させるAPI連携ツール

LLM APIと外部サービスの統合

LLM APIは、単体で使うよりも、外部サービスと連携させることで、その能力を最大限に発揮します。

- Google Workspace 連携:Gemini APIを使って、Google ドキュメントやスプレッドシートのデータ処理を自動化。

- GitHub 連携:OpenAI APIを使って、コードのレビュー、バグの説明、ドキュメントの作成を自動化。

h3. 効率的な開発のためのAPIテストとデバッグ

無料LLM APIでも、エラー処理やデバッグは必要です。

API テストツール(Postmanなど)を使って、API リクエストの形式や認証情報が正しいかを確認してください。

特に、無料枠のレート制限に達した際に、APIから返されるエラー(404や429など)を正しく処理することが重要です。