「従業員にCopilotの便利さを活用させたいが、機密情報や社内データがAIの学習に使われてしまうのではないか?」

企業のIT管理者やセキュリティ担当者の皆様が、今、最も抱える大きな課題の一つが、この「Copilotを学習させない」というテーマでしょう。

AIアシスタントの進化は業務効率化を大幅に向上させる一方で、Copilot データ保護と情報漏洩対策は、もはや組織のセキュリティ戦略において不可欠な要素となっています。

今回の記事は、PC初心者の方でも分かりやすく、かつ情報システム部門の担当者、IT管理者、セキュリティ担当者といった専門的な視点を持つ方々にも十分な知識と解決策を提供できるよう構成されています。

私たちは、GitHub CopilotとMicrosoft Copilot for Microsoft 365の二つの主要なAIサービスに焦点を当てます。

- 学習を停止させる設定の仕組み

- Copilot セキュリティ設定の手順

そして2025年最新のポリシーと管理方法までを徹底的に解説します。

このガイドを読むことで、あなたはAIの利用による生産性向上というメリットを享受しつつ、データ保護という重要な責任を果たすための完全な戦略を構築できます。

あなたの組織の情報セキュリティを強化してください。

Copilotを安全かつ適切に運用するための最初の一歩を踏み出しましょう。

Copilotが学習する仕組みとデータ保護の重要性

要点: Copilotは、利用者のコードや入力内容を基にモデルを改善する「学習」を行う可能性があります。

特に企業利用においては、機密情報や個人情報の意図しない流出や学習を防ぐためのデータ保護が最重要課題です。

Copilot 学習データオプトアウトの基礎

Copilotを安全に利用するためには、まずAIが「何を」「どのように」学習するのかを正確に理解する必要があります。

GitHub CopilotとMicrosoft Copilotの違い

「Copilot」という製品名は、主に二つの異なるサービスを指します。学習データの取り扱いも大きく異なります。

| サービス | 主な利用目的 | 学習の仕組み | データ保護のレベル |

| GitHub Copilot | コードの生成、補完 | プロンプトや生成されたコードを匿名化し、モデル改善に利用される可能性がある | オプトアウトの設定が必要 |

| Microsoft Copilot for Microsoft 365 | Word、Excel、Teamsなど365内での業務支援 | 顧客データがモデル学習に利用されることはない(デフォルトで保護) | エンタープライズレベルの厳格な保護 |

注釈: プロンプト

AIアシスタントに対して、ユーザーが入力する指示や質問のことです。プロンプトの内容が、AIが生成するコードや応答の品質を決定します。

学習データ利用の具体的な内容

GitHub Copilotの場合、ユーザーが入力したコードの断片やプロンプトの内容は、一定の処理を経てモデルの改善、つまり学習に使用される可能性があります。

この「学習」とは、最終的に多くのユーザーへの提案の精度を向上させるためのAIのトレーニングを指します。

しかし、企業が扱うソースコードには独自のアルゴリズムや機密情報が含まれています。

そのため、これらが他のユーザーへの提案に影響を与えたり、意図せず外部に流出したりするリスクを防ぐ必要があります。

これが「Copilot 学習させない」設定の最大の目的です。

Copilot データ保護が企業に不可欠な理由

Copilot データ保護は、単なるITポリシーではなく、企業の存続を左右する重要な戦略です。

情報漏洩対策と法的責任

- 社内のソースコード

- 顧客情報

- 未発表の製品情報

などが意図せずCopilotの学習に利用された場合、情報漏洩のリスクが発生します。

これは競争優位性の喪失だけではありません。

個人情報保護法やGDPRなど各国の法的規制への違反につながる可能性があります。

企業は利用者のデータを保護する責任を負います。

セキュリティとコンプライアンスの遵守

多くの業界や企業には、機密データの処理に関する厳格なセキュリティ基準とコンプライアンス要件があります。

Copilotを業務で使用する際は、これらのルールを遵守していることを管理者が確認しましょう。

ポリシーを設定しなければなりません。

特に、金融や医療など機密情報を扱う業界では不可欠な取り組みです。

GitHub Copilotを学習させない設定手順

要点: GitHub Copilotの学習データ利用を停止するには、組織または個人のアカウント設定で「パブリックコードと一致する提案」の除外と「スニペット」の収集の無効化を実施します。

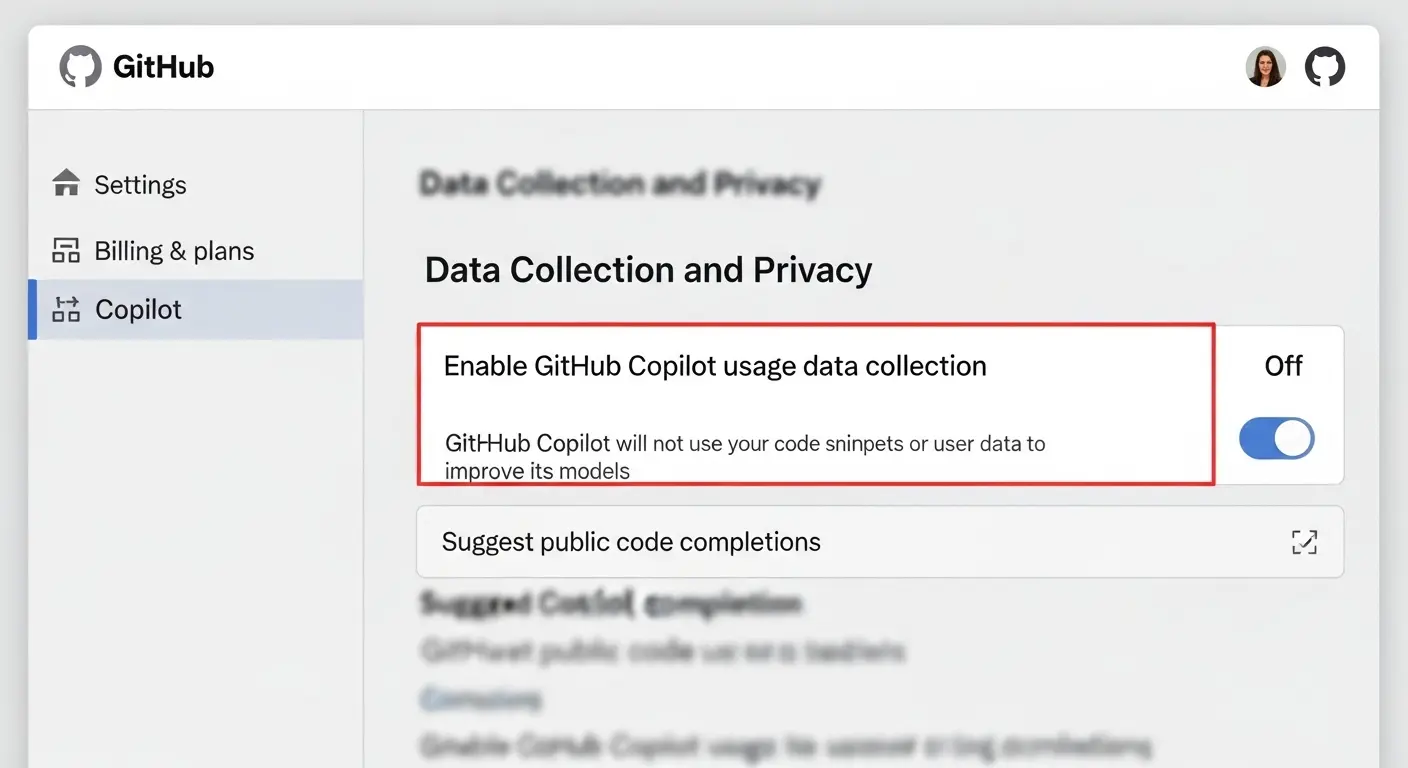

GitHub Copilot セキュリティ設定の確認と変更

GitHub Copilotの学習を停止させる設定は、

- 管理者権限を持つユーザーが組織単位で行う方法

- 個人アカウント単位で行う方法

の二種類があります。

組織単位でのCopilot 学習データ オプトアウト(推奨)

企業利用では、社員ごとの設定漏れを防ぐため、組織単位での設定変更が強く推奨されます。

- GitHub Enterprise アカウントにサインイン。管理者画面へ移動します。

- 「Copilot ポリシー」または「Copilot 設定」ページを開きます。

- 「Copilot によるコードスニペットの収集と処理」という項目を見つけます。

- この項目を「無効(Disabled)」または「Copilot のトレーニングに使用しない(Do not use for training)」に変更します。

この設定を行うことで、組織全体の全ユーザーの入力データや生成コードがCopilotの学習データとして利用されることを防ぎます。これは最も確実なCopilot データ保護の手順です。

個人アカウント単位での設定変更

個人開発者や小規模チームで、組織機能を利用していない場合は、個々のユーザーが以下の手順で設定します。

- VS Codeなど使用しているエディタのCopilot 拡張機能設定を開きます。

- 「GitHub Copilot: テレメトリー(利用履歴)を送信」や「GitHub Copilot: 提案の利用状況を共有」といった項目を見つけます。

- これらの項目を「オフ」に設定します。

注釈: テレメトリー

システムの利用状況や性能データを自動で収集し、開発元へ送信する仕組みです。Copilotでは、ユーザーが生成したコードの断片や操作履歴などがこれに該当し、モデル学習に利用される情報が含まれる可能性があります。

パブリックコード一致による情報漏洩対策

Copilotはトレーニングデータとして大量のパブリックコードを参照しています。

このため、入力内容次第では、学習データ内のコードと酷似したコードを提案してしまう可能性があります。

これが「著作権」や「情報漏洩」の問題に発展する原因になります。

パブリックコード一致の防止設定

このリスクを防ぐため、GitHub Copilotには「パブリックコードと一致する提案をブロックする」という強力な機能が用意されています。

- 組織または個人のCopilot 設定画面へ移動します。

- 「パブリックコードと一致する提案を許可」という項目を「拒否(Block)」または「無効」に設定します。

この設定は、学習データの利用停止とは別に、今まで学習したデータからの提案自体を制御するため、著作権問題の回避や機密データ流出防止の観点から非常に重要です。

Microsoft Copilot for Microsoft 365のデータ保護戦略

要点: Microsoft Copilot for Microsoft 365(M365 Copilot)は、Microsoftのセキュリティ基盤に基づき、デフォルトで学習データとして利用されることはありません。

重要なのは、その仕組みを理解し、社内のアクセス制御を強化することです。

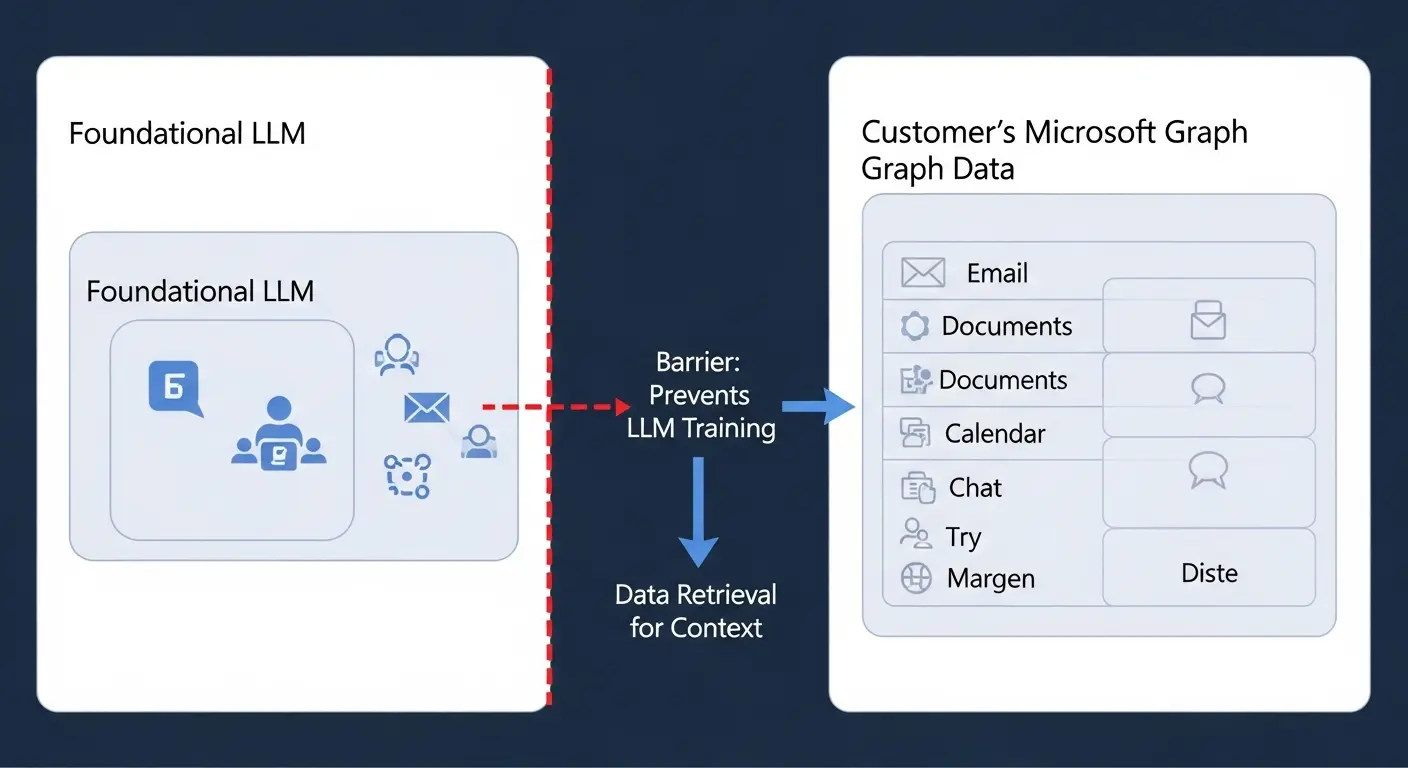

M365 Copilotを学習させない仕組みの理解

M365 Copilotは、GitHub Copilotと異なります。

最初から企業利用を前提とした設計がされています。

この設計の核となるのが「二重の保護層」です。

企業データとLLMの論理的分離

M365 Copilotは、Microsoft Graph(Teams、Outlook、SharePointなど365サービス内のデータ)とLLM(大規模言語モデル)の間に論理的な境界線を構築しています。

- ユーザーがCopilotに質問や指示を入力すると、まずそのプロンプトが処理されます。次に権限のある範囲の組織データだけがMicrosoft Graphから抽出されます。

- この抽出されたデータはLLMに渡されますが、LLMは応答を生成する目的以外にこのデータを「学習」として永久に保存したり、モデル自体を改善したりする目的では使用しません。

この「論理的分離」により、最初からCopilot 学習させないという状態が実現されています。この仕組みは企業のセキュリティ管理者にとって安心できる重要な情報です。

Microsoft Copilot ポリシーと信頼の基盤

M365 Copilotのデータ保護は、Microsoftの厳格なポリシーに基づいています。

- 顧客のデータ(プロンプト、応答、参照されたドキュメント)は、Copilotの基盤となる大規模言語モデルのトレーニングには使用されません。

- データは組織のテナント境界内に留まり、外部へ流出することはありません。

これらのポリシーはMicrosoftの公式ドキュメントに明確に記載されており、企業が信頼して利用できる基盤となっています。

Copilot 情報漏洩対策としてのアクセス制御

M365 Copilotで真に重要な情報漏洩対策は、「学習させない」設定よりも、「Copilotに何を見せるか」というアクセス制御の強化にあります。

ゼロトラスト原則と権限の見直し

Copilotはユーザー本人がアクセス許可されている全てのデータを参照できます。

このため、「誰でも見られる状態」になっている機密ドキュメントがある場合、Copilotを通して意図せず情報が共有されてしまう可能性があります。

- 解決策: ゼロトラスト原則に基づき、Entra ID(旧 Azure AD)を利用したアクセス制御を厳密に実施します。不必要な共有リンクを削除し、ドキュメントの権限を「必要最小限」に見直します。

Microsoft Purviewによる機密情報の保護

Microsoft Purview Information Protection(旧 Azure Information Protection)を活用することで、ドキュメント自体に機密ラベルを付与します。

暗号化することが可能です。

- Copilotは暗号化されたラベル付きドキュメントの内容を参照できますが、ラベルのポリシーに基づいて出力が制御されます。例えば、「社外秘」ラベルの内容を含む応答を外部ユーザーに見せないように制御できます。

この技術は「データから始める情報漏洩対策」として機能します。

Copilotの利便性を維持しながら、情報を保護する戦略として非常に有効です。

2025年最新のCopilot 企業利用とポリシー

要点: 2025年、Copilot 企業利用は高度なガバナンス機能とポリシー設定が中心となります。

最新の機能を活用し、組織全体のセキュリティレベルを高めることが重要です。

Copilot ポリシーと企業管理者向け機能

Copilotを企業で安全に展開するため、Microsoft と GitHubは管理者向けの制御機能を大幅に強化しています。

ログ保持と監査機能の強化

最新のCopilot for Microsoft 365では、利用者によるアクティビティ履歴(プロンプト、応答、参照されたドキュメント)を監査ログとして保持する機能が強化されました。

- 管理者はこのログを利用。社員がどのような情報を入力し、どのような機密データを参照しているかを定期的に監視できます。これにより、不適切な利用や潜在的な情報漏洩の発生源を特定し、迅速な対処を行うことが可能になります。

Copilot ポリシーによる利用制限

組織のポリシーに基づき、Copilotの利用を制限する機能も進化しています。

- 例えば、「特定のチームや部署のみCopilot を利用可能にする」、「外部ウェブ検索機能を無効にする」、あるいは特定のファイル形式(極秘文書)の参照を禁止するといった細かい制御が実現できます。

企業利用のためのセキュリティチェックリスト(2025年版)

Copilotを安全に導入。

「学習させない」ポリシーを徹底するために、以下のセキュリティチェックリストを確認してください。

| 項目 | 内容 | 理由と対策 |

| 学習データ無効化 | GitHub Copilotのオプトアウト設定を組織単位で実施したか。 | 社員の入力コードがモデル学習に使われることを防止します。 |

| アクセス権限最小限化 | M365 環境で、全ドキュメントの権限を「必要最小限」に見直したか。 | Copilotが機密情報を参照し、意図せず共有するリスクを防ぎます。 |

| Purviewラベル適用 | 機密ドキュメントにMicrosoft Purview の機密ラベルを適用したか。 | データ自体を保護し、Copilotの応答もポリシーに従って制御されます。 |

| 利用ログ監査設定 | Copilot の利用アクティビティログを定期的に監査する体制を構築したか。 | 不適切な利用や潜在的な情報漏洩の兆候を早期に検知します。 |

| 社員教育 ( プロンプト の リスク ) | 社員に対し、機密情報をプロンプトに入力しないよう教育を実施したか。 | AI利用リテラシーを向上させ、ヒューマンエラーを最小限に抑えます。 |

よくある質問と回答

Copilot 学習データ オプトアウトをすると何ができなくなるのですか?

機能への影響とメリットの維持

Copilot 学習させない設定(オプトアウト)を行った場合、基本的にCopilotのコード補完や応答生成機能自体は停止しません。

- 影響: あなたの組織が入力した固有のコードパターンが、Copilotのグローバルなモデル改善に寄与することはなくなります。また、パブリックコードと酷似するコードの提案が表示されなくなります。

- メリットの維持: Copilotが持っている既存の知識や機能はそのまま利用可能です。企業の機密保持を優先しながら、AIの恩恵を受けられる安全な状態を維持できます。

Microsoft 365 Copilotの場合も別途 学習させない設定が必要ですか?

M365 の場合の結論と注意点

M365 Copilotに関しては、管理者側で「学習させない」という特別な設定を追加で行う必要はありません。

- 理由: 前述の通り、M365 Copilotは設計思想自体がセキュリティ優先で、顧客データ(プロンプトや応答)はモデル学習に利用されないように論理的に隔離されています。

- 注意点: 「学習させない」設定は不要ですが、「誰に何を見せるか」というアクセス制御の確認と強化は必須です。この管理を怠ると、Copilotが機密情報を参照し、応答に含めてしまうリスクが発生します。

Copilot 企業利用の際に必ず策定すべきポリシーは何ですか?

企業向け Copilot 利用ポリシーの骨子

Copilot 企業利用を安全に進めるためには、以下の要素を含めた明確な社内ポリシーを策定し、従業員に周知徹底する必要があります。

- 機密情報入力禁止のルール: プロンプト内に絶対に含まれてはいけない情報(顧客名、契約内容、パスワードなど)を明確に定義します。

- 生成コードのレビュー義務: Copilotが生成したコードは必ず人間がセキュリティ脆弱性や著作権違反がないかを確認するルールを設けます。

- 利用ログと監査への同意: Copilotの利用データが監査目的で管理者に収集 分析されることを従業員に同意させます。

- 使用可能なCopilotの種類: 組織が許可する Copilot サービス(例:M365 Copilotは可、無料版 GitHub Copilotは不可)を明記します。

2025年最新のCopilot セキュリティ設定と対策

要点: 最新のCopilot セキュリティ設定では、機密情報の処理を細かく制御する新機能が追加されています。

これらの機能を活用し、より高度な情報漏洩対策を実現できます。

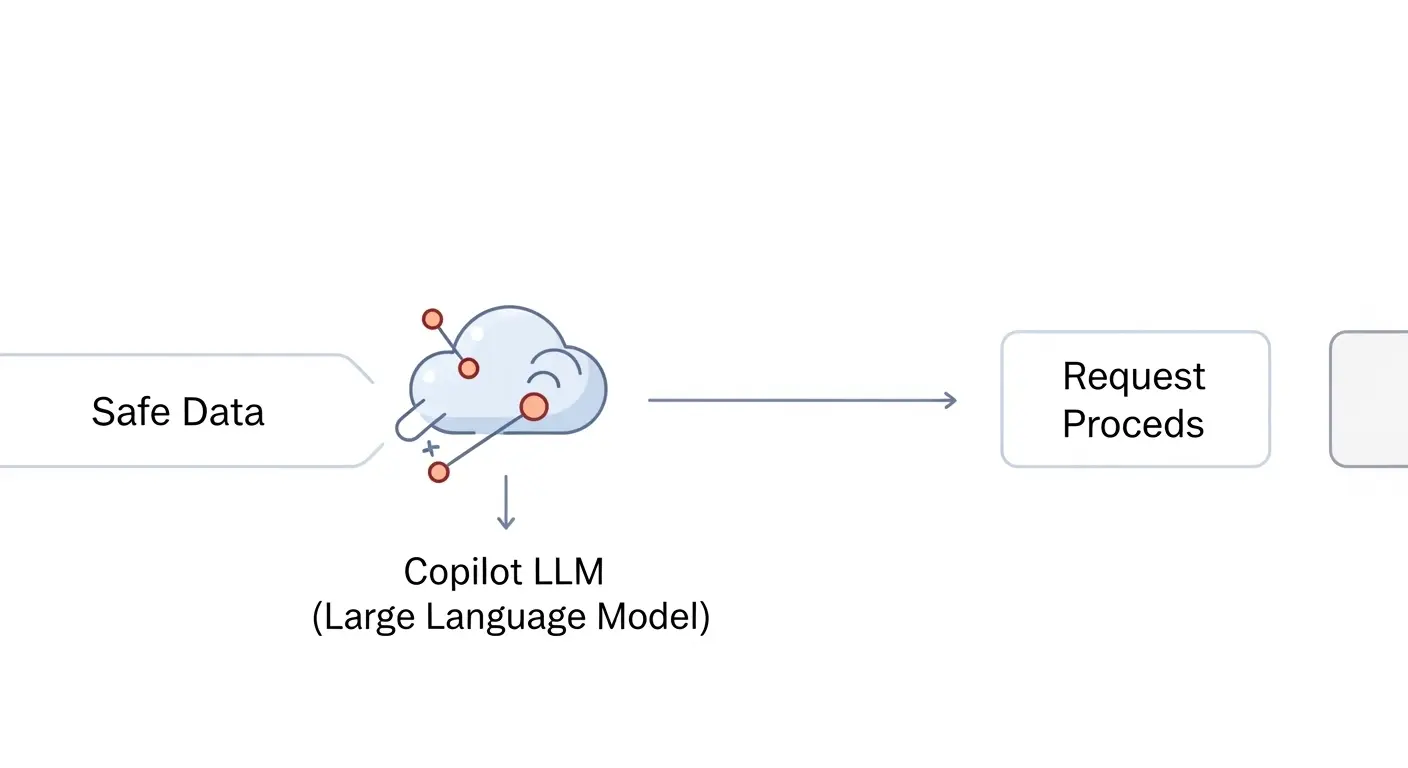

Copilot セキュリティ設定の進化:DLP連携

2025年、Copilotのセキュリティ機能はDLP(Data Loss Prevention:情報漏洩防止)システムとの連携により大幅に強化されました。

Copilot と DLP の統合によるリアルタイム検知

Microsoft Purview DLP と M365 Copilotが統合されたことで、ユーザーがCopilot Chat に機密情報(例:大量のクレジットカード番号やマイナンバー)を入力した際、DLPポリシーがリアルタイムに検知します。

その応答をブロックすることが可能になりました。

- 機能例: ユーザーが「この顧客リストから100人分の個人情報を抜粋して要約して」と指示した場合、リスト内に定義済みの機密データが含まれていれば、Copilotは応答を停止します。

この仕組みは、プロンプト入力時のヒューマンエラーや悪意ある情報抜き出しを防ぐ上で極めて有効な情報漏洩対策となります。

企業向けCopilot学習データオプトアウトの例外と制御

全てのデータを一律に「学習させない」設定にするだけでは、Copilotの利便性が損なわれる場合があります。

ローカルモデルによる学習の選択

一部の企業向けCopilotサービス(例:Azure OpenAI Serviceと連携したカスタム Copilot)では、組織固有の知識ベース(ナレッジ)を学習させるニーズがあります。

- 解決策: この場合、「グローバルなCopilotモデルの改善」とは分離した「自社専用のローカルモデル」を構築します。そのローカルモデル内でのみ社内データを学習させる戦略が有効です。このローカルモデルの学習データは、外部へ流出することはありません。

パーソナライズ機能とのバランス

Copilotには、ユーザーごとの利用履歴や好みに応じて提案を調整する「パーソナライズ」機能があります。

- パーソナライズを維持するためには、限定的なアクティビティログ(例:どの機能を使ったか)を収集することが必要です。管理者は「モデル学習のためのデータ」と「パーソナライズのためのログ」の違いを理解し、許容できる範囲でログ収集を許可するか否かを判断する必要があります。

Copilot 企業利用のための 導入 手順 と 教育

要点: 技術的な設定だけではありません。「Copilotを学習させない」ポリシーを守るために、全従業員への教育と周知徹底が不可欠です。

企業:管理者向けCopilot導入7ステップ

情報漏洩対策を徹底したCopilotの導入は戦略的に進める必要があります。

- Copilotポリシーの策定: 利用ルール、禁止事項、機密情報の定義を明確に記載した文書を作成します。

- 学習データのオプトアウト設定: この記事 「2.1.1. 組織単位でのCopilot 学習データ オプトアウト(推奨)」を参照して組織単位で設定します。

- アクセス権限の最小限化: M365 環境の全ドキュメントとサイトの権限を見直します。

- DLPとPurviewの適用: DLP ポリシーを設定。機密情報に保護ラベルを付与します。

- パイロット運用と検証: 一部のチームで限定的に運用を開始。ログを分析して問題がないかを検証します。

- 全従業員への教育と周知: 作成したポリシーと安全なCopilotの使い方を研修や資料で教育します。

- 定期的な監査と見直し: 半期に一度は設定とログを監査し、最新情報に基づいてポリシーを更新します。

社員向けAI利用リテラシー教育の重要性

「Copilot 学習させない」設定は技術的な解決策ですが、最終的に情報漏洩を防ぐのは人の行動です。

プロンプトと機密情報のリスク

Copilotが優れているからこそ、「このドキュメントは見られるまい」と誤った認識で機密情報を入力してしまうリスクがあります。

- 教育内容のポイント: 「Copilotはあなたのアクセス権限の範囲で動いている」という事実を明確に伝えましょう。不注意による情報漏洩の発生を防ぎます。

倫理と責任に基づく利用の推進

AIを使って生成したコードや文書の「最終的な責任は利用者ににある」という点を徹底します。

Copilotは便利な支援ツールであり、自動で品質や法的な問題を保証するものではないことを教育します。

まとめ:Copilotを活用した安全な企業戦略

Copilotを企業で導入し、「学習させない」ポリシーを実現するためには、「技術的な設定」と「人間の教育」の両輪が不可欠です。

- 知識の定着: GitHub CopilotとM365 Copilotの学習の仕組みの違いを理解し、それぞれに応じた対策を実行します。

- 解決の実行: 組織単位でのオプトアウト設定を確実に行い、DLPやアクセス制御による情報漏洩対策を強化します。

- 鮮度の維持: 2025年最新のDLP連携や監査機能を活用し、ポリシーを定期的に見直します。

このガイドを参考に、Copilotを安全な環境で最大限に活用し、組織全体の生産性とセキュリティを両立させてください。

サイト外リンク

- Microsoft Purview 公式ページ: https://www.microsoft.com/ja-jp/security/business/microsoft-purview

- GitHub Copilot Docs: https://docs.github.com/ja/copilot

- Microsoft Copilot for Microsoft 365 データ、プライバシー、セキュリティ: https://learn.microsoft.com/ja-jp/copilot/microsoft-365/microsoft-365-copilot-privacy

- Microsoft Entra ID (旧 Azure AD) 公式: https://www.microsoft.com/ja-jp/security/business/identity-access/microsoft-entra-id