要点:2025年から2026年にかけて、生成aiの導入は企業の競争力を左右する重要な戦略となりました。

同時にmicrosoftのcopilot enterpriseが提供するセキュリティと商用データ保護の理解が不可欠です。

「aiを活用したいが、社外秘の情報が学習に使われてしまうのではないか」という不安を抱える情シスやセキュリティ担当者は少なくありません。

実際、パブリックなサービスでは入力したデータがモデルの改善に利用されるリスクが潜むため、厳格なガバナンスが求められます。

本記事では、microsoft learnや公式の最新情報に基づき、copilot enterpriseがどのように機密情報を保護し、コンプライアンスを維持しているのかを徹底解説します。

- microsoft purviewによる可視化

- githubでの安全なコード生成

さらには2026年のトレンドである自律型エージェントの運用までを網羅しました。

当初心者の方でも、初期の設定からリスク管理のポイントまでをステップごとに学ぶことができます。

組織全体の生産性を高めるために、まずは正しい知識を取得し、安心してaiを導入できる体制を整えましょう。

Copilot Enterprise データセキュリティの基盤

要点:エンタープライズ向けのプランでは、商用のデータ保護(edp)が適用されます。

ユーザーの入力内容やプロンプトが外部へ流出するのを防ぎます。

microsoftが提供するcopilot enterpriseは、企業がaiを導入する際に最も懸念するリスク、すなわち機密情報の漏洩に対して強固な境界を構築しています。

組織のテナント内で処理されるすべての情報は、microsoftの商用モデルのトレーニングには使われません。

EDPによる厳格な分離

edpとは、商用データ保護を指します。

サービスを利用する間のコンテンツがパブリックな生成aiモデルの学習に活用されないことをコミットメントするものです。

個人向けの無料版やproプランとは異なります。

enterpriseプランでは会社の知的財産が守るべき資産として隔離された環境で保存されます。

暗号化と認証の仕組み

データの転送中および保存時には、高度な暗号化技術が適用されます。

microsoft entra(旧azure AD)によるsso(シングルサインオン)認証を介してログインを制御します。

許可されたユーザーのみがアクセスできるディレクトリ構成を維持します。

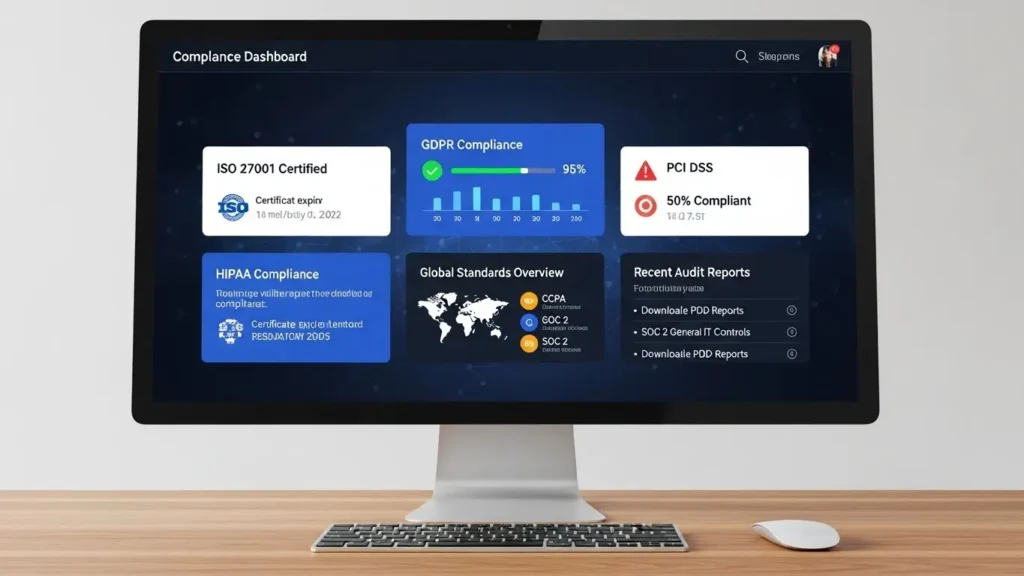

Copilot Enterprise コンプライアンスと規則

要点:iso 27018やgdpr、hipaaなどのグローバルな規則に準拠し、法的責任を果たすための監査ログ機能も備えています。

情報システム部門の担当者にとって、コンプライアンスの遵守は不可欠な要素です。

microsoftは、iecなどの国際基準に基づいたセキュリティ対策を実施しております。

地域ごとの法律や業界のガイドラインに応じた運用が可能です。

監査ログと可視化

管理者は、組織内のユーザーがどのようなプロンプトを使用し、どのファイルを参照したかのイベントを監査することが可能です。

microsoft purviewとの連携により、機密度ラベルが付与されたドキュメントへのアクセスを監視します。

不適切な共有を早期に検出する体制を整えることができます。

地理的なデータ保持

euなど、特定のリージョンにデータを格納する必要がある場合も、microsoftのインフラを活かして調整できます。

dpa(データ処理補遺)などの契約条項により、法的な安全性を担保しながら最新のaiを使いこなすことができます。

Copilot Enterprise リスク管理の実践

要点:著作権侵害の懸念や有害な応答を防ぐため、静的解析や最小権限の原則を取り扱いに含めた運用が推奨されます。

aiの挙動には属人的なばらつきが発生する可能性があるため、組織横断的なルールの策定が重要です。

copilot enterpriseでは、出力の品質を維持し、脆弱性を回避するための機能が多数プログラムされています。

著作権保護とIP補償

microsoftは、お客様が適切なガードレールの下でサービスを利用している限り、生成されたコンテンツに関わる著作権の問題に対して、法的な保護を提供する声明を出しています。

これにより、ビジネスの現場で安心してaiを創作に使えます。

セキュリティポリシーの設定

管理者サイトから、web 検索(bing)の有効無効や、github copilotにおけるパブリックコードとの一致をブロックする設定などを細かくカスタマイズできます。

最小限のアクセス権限を継承させることで、内部からの情報漏洩リスクを最小に抑えられます。

Microsoft Purview Copilot Enterpriseの役割

要点:purviewを活用することで、機密情報の自動識別と保護が可能になりました。

ガバナンスが飛躍的に向上します。

2025年から2026年にかけての最新トレンドは、aiとガバナンスツールの完全な統合です。

microsoft purviewは、

- exchange

- sharepoint

- onedrive

- teams

を横断してデータをスキャニング(scanning)します。

社外秘の情報がaiを介して誤って社外に公開されるのを防ぐ役割を担います。

データの可視化と分類

ラベルが済みのドキュメントは、aiが応答を作成する際にもその機密レベルを尊重します。

管理者は、どの部署でどの程度aiが活用され、どのようなリスクが潜むかをレポートで把握します。

セキュリティ戦略を見直すことができます。

インシデントの早期復旧

万が一の不正アクセスや違反が疑われる状況では、ediscovery(電子情報開示)機能を使います。

対象のチャット履歴を抽出して調査できます。

これは他社のllmサービスにはない、microsoftエコシステムならではの強みです。

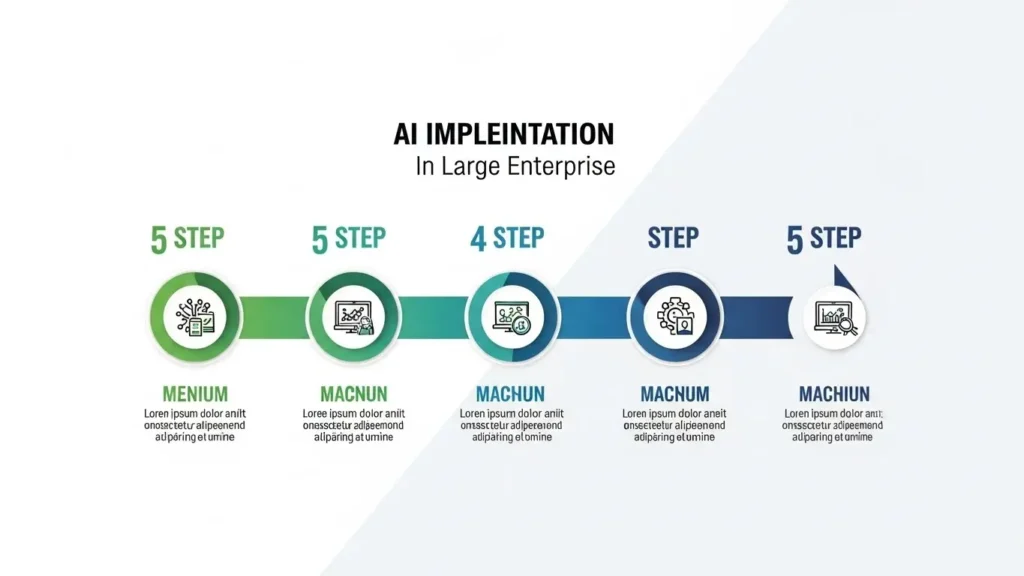

Copilot Enterprise 具体的な導入ステップ

要点:導入を成功させるためには、単なるライセンスの付与ではありません。

組織内のディレクトリや権限を整理し、段階的に範囲を広げるアプローチが最適です。

企業がaiを実務に取り入れる際、初期段階での準備が後の運用コストに大きく影響します。

以下のステップに沿って、スムーズな展開を目指しましょう。

ステップ1:現状のデータ権限とガバナンスの確認

まず、

- 社内のsharepoint

- onedrive

- teams内のファイル

に対するアクセス権限が適切か見直します。

copilotはユーザーが参照可能なすべての情報を検索対象とします。

そのため、過剰な共有設定(everyoneへの公開など)があると、意図しない内部情報漏洩の原因となります。

ステップ2:パイロットチームによる検証と評価

全社への展開の前に、it部門や開発者、企画担当者など、aiの活用が期待できるメンバーで構成されたパイロットグループを作成します。

この段階でプロンプトの例や業務上の成功事例を収集し、自社の環境における安全性を検証します。

ステップ3:周知とトレーニングの実施

従業員に対し、aiを使う上での注意点やプライバシーポリシーについて教育を行います。

入力してはならない機密情報(個人情報や他社との秘密保持事項など)を明確にし、正しく使いこなすためのガイドラインを配布します。

情シス向けの初期設定チェックリスト

要点:管理者はmicrosoft 365管理センターやgithubの設定画面を通じて、組織のポリシーに合致した制御を適用する必要があります。

情シス(情報システム部門)の担当者が、運用を開始する直前に必ずチェックすべき項目をまとめました。

これらの設定を事前に整えることで、安全で効率的なai環境を提供できます。

1. アクセス制御と認証の設定(Identity)

- microsoft entraによるssoの設定が完了しているか。

- 条件付きアクセスを用いて、未承認のデバイスからのサインインを制限しているか。

- ユーザーのロールに基づく適切なライセンス割り当てが済みか。

2. データ保護とプライバシーの設定(Privacy)

- 商用データ保護(edp)が有効であることを確認したか。

- microsoft purviewで機密情報の検出ルールが動作しているか。

- web検索(bing等)を介した外部データの取得を、部署ごとのポリシーに応じて許可または禁止しているか。

3. プロンプトと出力のガバナンス(Quality)

- github copilotを利用する場合、パブリックコードに一致する提案を除外するオプションを有効にしているか。

- プロンプトのログを監査し、異常な挙動を検知する仕組み(セキュリティインシデント対応)を策定しているか。

4. コンプライアンスと記録(Audit)

- 監査ログの保存期間が法的義務や社内規定に一致しているか。

- 定期的なレビューを行うための担当者が選任されているか。

2026年最新:AIエージェントの動向と展望

要点:2026年には、ユーザーが指示を出すのを待つのではなく、背景や文脈を理解して自律的に動くエージェントがメインとなります。

microsoftは、copilot studioを介して、企業が独自のエージェントを構築できるプラットフォームの提供を強化しています。

これらのエージェントは、社内のdbやapiと接続し、人間の代わりに複雑なワークフローを処理します。

マルチエージェントによる業務効率化

例えば、新しく入社した従業員のオンボーディングでは、一つのエージェントが契約文書のチェックを行います。

別のエージェントがpcのセットアップを指示するといった連携が自動で走ります。

これらの動作はすべてエンタープライズレベルのセキュリティ境界の内側で行われるため、利便性と安全性を高度に両立できます。

用語解説:初心者向けの注釈

- LLM(大規模言語モデル):大量のテキストデータを学習し、人間のような文章を生成するaiの基盤技術です。

- ハルシネーション:aiがもっともらしい嘘(不正確な情報)を出力してしまう現象です。参照元を明示させることで回避しやすくなります。

- オプトアウト:ユーザーが特定の機能やデータ収集を「拒否」することです。セキュリティ上の理由で学習を拒否する際などに使います。

よくある質問と回答

要点:導入を検討中の方が抱える共通の悩みを、faq形式で解説します。

Q1:Copilot Enterpriseに入力したデータは他社のAI学習に使われますか?

いいえ。

enterpriseプランの契約では、お客様のデータはお客様のテナント内に留まります。

openaiや他社のモデルのトレーニングには一切利用されません。

Q2:情報の保存期間や削除はどうなっていますか?

組織の保持ポリシーに基づいて、メッセージやログの保存期間を設定できます。

アカウントを削除した後やサブスクリプションの終了時には、microsoftの標準的な手順に沿ってデータは完全に消去されます。

まとめ:強固なセキュリティでDXを推進

要点:安全性と生産性を両立させるためには、microsoft learnなどで最新情報を確認し、正しく設定を整えることが重要です。

2026年のビジネス環境では、aiの活用は不可欠ですが、それと同時にセキュリティポリシーの整備も欠かせません。

本記事で紹介した機能を活かし、機密を守りながら業務効率化を実現しましょう。

まずは無料のガイドをダウンロードするか、公式のセミナーに参加して理解を深めてください。