「LLM マルチモーダル」という言葉を耳にして、AIが画像や音声、さらには動画といった複数のデータを統合的に理解し、処理する能力に興味を持たれたのではないでしょうか。

これまで、大規模言語モデル(LLM)は主にテキストを扱う技術でした。

しかし、その能力が今、視覚や聴覚といったモダリティにまで拡張されました。

人間の認識に近い汎用性の高いAIへの進化を遂げています。

- 「LLM マルチモーダルって何?」

- 「GPT-4VやGeminiのような最新モデルで何ができるの?」

- 「開発やビジネスでどう活用すれば最適なの?」

といった疑問をお持ちのAI初心者の方から、最新情報を収集したいエンジニアやプロダクトマネージャーまで、この記事はすべての検索目的を満たすために作成されました。

今回の記事では、

- LLM マルチモーダルの基本知識

- 2025年最新のモデル動向(GPT-4V、Gemini、Llama 3 multimodalなど)

- 業務効率化を実現する活用事例

開発を成功させるための具体的な解決方法まで、徹底解説します。

これを読めば、LLM マルチモーダルの全貌を把握し、次の行動へと移せるはずです。

LLM マルチモーダルの基本概念と仕組み

要点:LLM マルチモーダルとは、テキストに加え、画像、音声、動画などの複数のモダリティ(データの形式)を同時に認識、理解します。

適切な回答を生成する技術です。

これにより、人間の自然な認識に近い複雑な処理が可能になります。

大規模言語モデル マルチモーダル 応用:AIの進化形

LLM(大規模言語モデル)は、膨大なテキストデータセットで学習され、自然言語処理(NLP)の能力を飛躍的に向上させました。

しかし、従来のLLMの主な制限は、「テキスト情報以外を直接扱うことができない」点でした。

ここで登場するのが、「マルチモーダル」技術です。

マルチモーダルとは、視覚、聴覚、言語といった複数の感覚(モダリティ)を統合することを指します。

LLM マルチモーダルは、LLMの言語理解能力に、画像認識や音声認識の技術を組み込むことで、単なるテキスト生成ツールから、世界をより深く理解できる汎用AIへと変革を遂げました。

(注釈:モダリティとは、AIが処理するデータの種類、または形式のことです。テキスト、画像、音声、動画などが主なモダリティです。)

マルチモーダルAIのアーキテクチャ

マルチモーダルAI、またはマルチモーダルモデル(MLLM)は、複数のモダリティを統合するために、特定のアーキテクチャを採用しています。

エンコーダとデコーダの構成

画像や音声といった非テキストデータをLLMが理解できる形式(トークン)に変換する役割を持つのが、「エンコーダ」です。

- 画像認識 自然言語処理 連携:

- 画像は、画像処理技術(例:ViTやCLIPのエンコーダ)を用いて視覚情報を抽出、LLMが扱える言語的な表現に変換されます。

- この変換されたデータとユーザーのテキスト入力(プロンプト)が統合され、LLMに入力されます。

- LLM(デコーダ):

- 統合された情報を基に、LLMが推論を行い、自然言語の回答や、場合によっては画像生成や音声出力といった異なるモダリティでの出力を行います。

(注釈:エンコーダは入力データをAIが理解しやすい形式に符号化する部分、デコーダは符号化された情報から最終的な回答やコンテンツを生成する部分を指します。)

LLM マルチモーダルの重要性と将来性

LLM マルチモーダル技術の重要性は、人間のコミュニケーションや認識の仕方に近づく点にあります。

私たちは単なる文字だけでなく、

- 目の前の視覚情報

- 聞こえてくる音声

- 周囲の環境情報

を同時に処理して世界を理解しています。

この技術が発展することで、以下のような未来が実現します。

- より自然な対話:テキストだけでなく、画像や音声を使った質問にも自然に応答できるチャットボットやエージェントの開発。

- 知識の高度な活用:専門分野の図表や論文資料(画像)を理解し、正確な情報を提供する知識検索サービスの向上。

- 複雑な業務の自動化:製造業の検査や医療分野の診断支援など、複数データ分析が必要なタスクの自動化。

LLM マルチモーダル最新動向と主要モデル比較

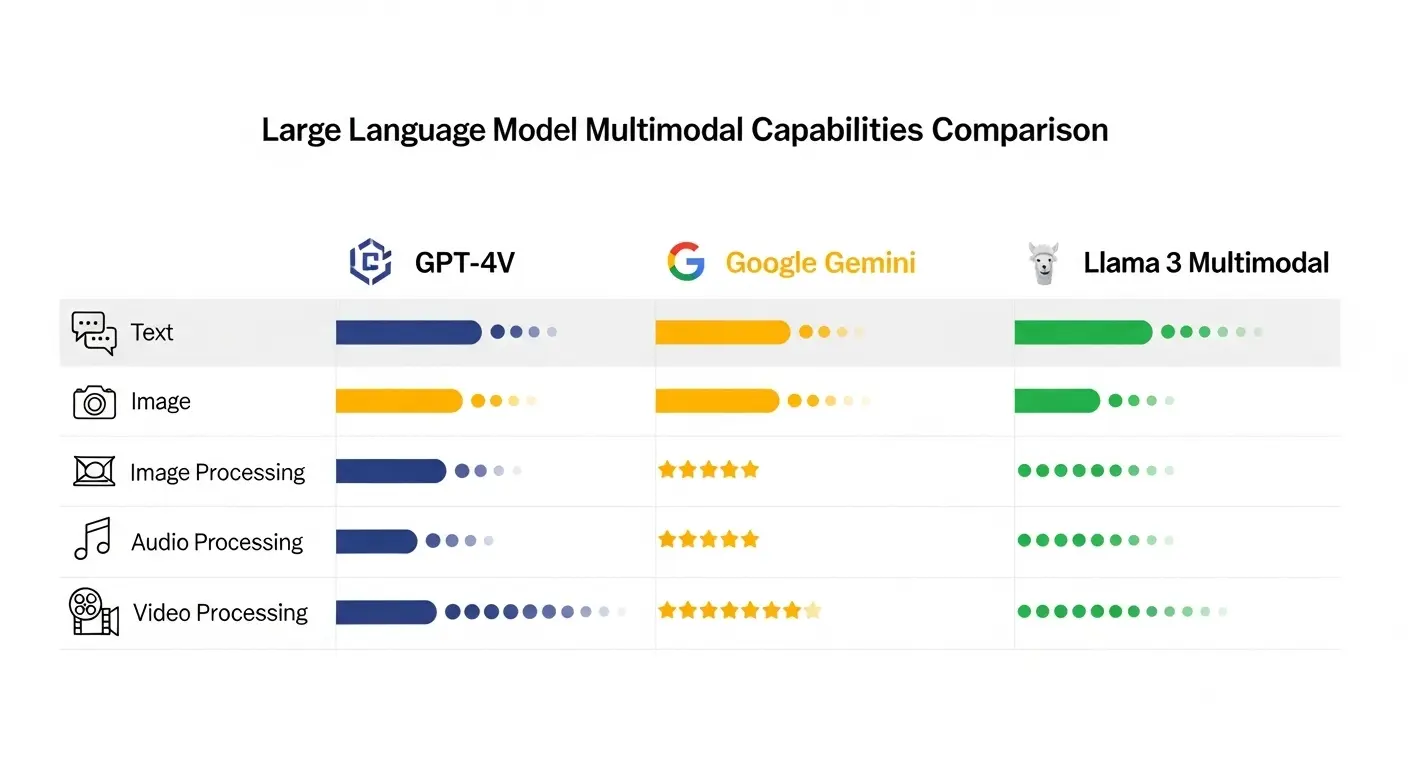

要点:2025年現在、LLM マルチモーダルの分野はGPT-4V、Gemini、Llama 3 multimodalといった主要モデルの進化により、競争が激化しています。

各モデルの特徴を把握し、目的に応じて適切に使い分けることが重要です。

主要 LLM マルチモーダルモデル 一覧

| モデル名 | 提供元 | 主なマルチモーダル能力 | 適用分野と特徴 |

| GPT-4V | OpenAI | 画像の理解と分析(Vision) | 汎用性が高く、画像に関する複雑な推論、説明、回答生成に優れる。GPTシリーズの信頼性も特徴。 |

| Gemini | 画像、音声、動画を統合的に処理 | 最初からマルチモーダルとして設計され、複数のモダリティの同時理解に強み。リアルタイム処理能力も高い。 | |

| Llama 3 multimodal | Meta | 画像(入力)と テキスト(出力) | オープンソースモデルの中で最も注目され、企業内ローカル環境での導入を推進。コミュニティの支援も豊富。 |

| Claude 3.5 Sonnet | Anthropic | 画像、図表、グラフの理解 | 安全性と長いコンテキスト理解に優れ、専門的な資料分析やレポート作成支援に適している。 |

GPT-4V:画像理解のパイオニア

GPT-4V(GPT-4 Vision)は、OpenAIが提供する画像理解能力を搭載したLLMです。

テキストと画像の両方を入力として受け付け、その内容について質問に回答したり、説明を生成したりすることが可能です。

画像認識 自然言語処理 連携の具体例

GPT-4Vの優れた点は、単なる画像認識(「何が写っているか」)に留まらず、「この図表の変化の理由を説明して」といった論理的な推論を伴う質問にも正確に答える能力です。

- 例:複雑なグラフの画像をインプットし、「このグラフが示している内容の要約と、今後のトレンド予測」を要求すると、データ分析官レベルの回答を得られます。

(注釈:GPT-4Vは、GPT-4にVision(視覚)機能を統合したモデルです。複雑な画像や図表を認識し、自然言語で応答できます。)

Gemini:ネイティブなマルチモーダルAI

Googleが開発したGeminiは、最初からマルチモーダルモデルとして設計された点で、既存のLLMに視覚機能を追加したモデルとは一線を画します。

- テキスト

- 画像

- 音声

- 動画

を共通の基盤モデルで処理し、より迅速かつ一貫性の高い理解を実現しています。

リアルタイム処理と応用

Geminiの特徴の一つは、エッジデバイスやモバイル環境での動作に適した軽量モデル(Gemini Nano)も提供されている点です。

- 例:スマートフォンのカメラを通して見ている場所の情報をリアルタイムで解析し、「この花の名前と育て方」について音声で回答するといった、実生活に密着した応用が可能です。

Llama 3 multimodal:オープンソースの推進力

Metaが公開したLlama 3のマルチモーダル版(Llama 3 multimodal)は、オープンソースコミュニティにとって大きなインパクトを与えました。

商用利用も可能なライセンスで提供されています。

企業内ローカル環境でAIを運用したい企業や開発者に最適な選択肢となっています。

企業内でのカスタマイズと活用

Llama 3 multimodalはオープンソースであるため、企業が持つ独自のデータセットを使ってファインチューニングを行いやすい点が強みです。

- 例:製造業の企業が、社内の大量の製品設計図面とマニュアル(テキスト)を学習させることで、特定の部品画像に対する問い合わせに特化して正確に回答できるエージェントを構築できます。

(注釈:オープンソースモデルとは、モデルの構造やコードが一般に公開され、誰でも利用、修正、再配布できるAIモデルのことです。)

LLM マルチモーダル 活用事例と業務効率化戦略

要点:LLM マルチモーダルの応用は多岐にわたり、業務効率化から新規サービス開発まで幅広く貢献します。

特に、画像とテキストの連携は、データ分析やカスタマーサポートの現場で革命を起こしています。

LLM マルチモーダル活用事例:分野別解説

大規模言語モデル マルチモーダル 応用は、以下のように様々な分野で実用化が進んでいます。

1. 製造・検査分野:異常検知と保全支援

製造業では、製品の品質検査をカメラ映像(画像)で行い、その結果をLLMが解析してレポートを作成する仕組みが導入されています。

- 活用:生産ラインのカメラ映像をLLMがリアルタイムで監視し、外観の異常(例:ひび割れ、変色)を検知すると同時に、「どの部品のどの部分に異常がある」という詳細なテキスト説明と、過去の事例に基づいた修理手順を提示します。

- 効果:人手による検査の手間が大幅に削減され、検査精度が向上します。

2. 医療・診断分野:画像診断の補助

医療分野では、LLM マルチモーダルは医師の診断支援ツールとして期待されています。

- 活用:レントゲン画像やMRI画像(画像)と、患者の病歴(テキスト)を同時に入力し、「画像所見と病歴から考えられる病名と次の診療手順」を提案します。

- 効果:診断プロセスの効率化と、見落としリスクの最小限化に貢献します。

3. データ分析・マーケティング分野:コンテンツの自動生成

マーケティングやコンテンツ制作の分野では、複数のモダリティのデータ分析が可能なLLMを活用しています。

- 活用:商品の写真(画像)と、ターゲット顧客の問い合わせ履歴(テキスト)を入力し、「この商品に最適なSNS投稿用キャプションとハッシュタグ」を自動生成します。

- 効果:マーケティングコンテンツの作成効率が向上し、顧客ニーズにより合致した内容を提供できます。

LLM マルチモーダル 活用事例 の実現に向けた課題

LLM マルチモーダルの導入には、いくつかの課題も存在します。

- データの品質と整備:複数のモダリティのデータ(画像、テキスト、音声など)を統合し、適切な形式でデータセットを用意する手間。

- 推論コストと速度:画像データなどは情報量が膨大なため、テキストのみの処理に比べて推論時間が長くなり、コストも高くなる傾向。

- バイアスと公平性:学習データに偏りがある場合、生成される回答や認識にもバイアスが生じる可能性。

2025年最新のLLM マルチモーダル トレンドと将来展望

要点:2025年のLLM マルチモーダルのトレンドは、

- 自律的エージェントへの統合

- ローカル実行の進化

そして動画・3Dデータへの対応強化にあります。

これらの動向は、次のAI時代の「常識」を作ります。

LLMマルチモーダル最新動向:エージェントの自律化

最新のLLM マルチモーダルの研究動向では、単なる質問応答ツールとしてではなく、「マルチモーダル エージェント」としての能力強化に焦点が当てられています。

- マルチモーダル エージェント:環境(例:ウェブサイト、防犯カメラ、ロボットのセンサー)から画像、音声、テキストなどの情報を入力し、それを基に自律的に判断し、アクション(行動)を実行できるAIです。

- 例:自動運転車はカメラ映像(画像)やセンサーデータを認識し(マルチモーダル)、それに基いてハンドル操作(行動)を行います。

動画・3Dデータへの対応強化

今後、LLM マルチモーダルの主戦場となるのが、動画と3Dデータの理解です。

- 動画の理解:動画は連続した画像(フレーム)と音声の組み合わせであり、時間と空間のコンテキスト理解が必要です。Geminiなどの最新モデルは、動画データから「いつ、どこで、誰が、何をしているか」という複雑な情報を正確に抽出、要約できる能力を開発中です。

- 3Dデータの処理:建築や製造業で使われる3Dモデルや点群データを理解し、設計の問題点を検出したり、最適な構造を提案したりする技術の研究が進んでいます。

LLM マルチモーダル 活用事例:最新限定情報

2025年の最新トレンドとして、各社が限定的に公開を開始したサービスがあります。

| サービス名 | 独自の特徴と限定情報 |

| GPT-4V Action Edition | 画像認識と外部ツール(関数)の呼び出しを統合。ウェブサイトのUIを画像として入力し、「このボタンをクリックして」という指示で実際に操作を実行できる限定機能。 |

| Google Gemini Pro Video | 長時間の動画ファイルをアップロードし、その中から特定のシーンを検索したり、概要を自動生成したりする機能のプレビュー版を提供。 |

| Ricoh LLM for Manufacturing | 株式会社リコーが製造業向けに開発したLLMで、工場内のカメラ映像と設備データを統合し、予知保全機能を強化した限定導入事例を発表。 |

LLM マルチモーダルの高度な活用とAIO/LLMO対策

要点:LLM マルチモーダルを最大限に活用するには、応答の品質と検索性を高めるためのAIO(AI Optimization)や LLMO(LLM Optimization)といった最適化技術が不可欠です。

特に、画像入力に対するプロンプトの設計が成功の鍵を握ります。

LLM マルチモーダルのAIO対策:検索性を高める戦略

AIOは、AIサービスやアプリケーションにおける「検索結果の最適化」を指します。LLM マルチモーダルの場合、複数のデータ形式から得られる回答を、ユーザーが求める形式で適切に提示する工夫が必要です。

- 音声検索対策:音声で「この画像の説明と関連情報を簡潔に教えて」と質問された際、LLMの長文出力をそのまま流さず、最初の数文で結論を出すように制御する後処理の仕組みを導入します。

- マルチモーダルSEO:ウェブページに埋め込まれた画像や動画に対し、LLMが理解できるように詳細な代替テキストやキャプション、構造化データを記述し、AI検索エンジンからの評価を高める戦略です。

LLMO対策:画像入力に特化したプロンプトエンジニアリング

LLMOは、LLMの出力品質を最大限に高めるためのプロンプト設計技術です。

マルチモーダルLLMを扱う際は、テキストと画像入力の両方を最適化する必要があります。

1. 視覚コンテキストの明確化

画像をインプットする際は、LLMに「どの部分に注目すべきか」を明確に指示することが重要です。

- 例:「この画像全体ではなく、赤枠で囲まれた部分の外観特徴のみを詳細に説明せよ。」

- 効果:無駄な情報処理を最小限に抑え、回答の精度と速度を向上させます。

2. ゼロショットから少数ショットへの移行

LLMは、具体的な例(少数ショット)を示されると性能が向上します。

- 例:製造業の検査タスクであれば、「過去の良品画像と 不良品画像(画像)、および その説明(テキスト)を ペアで提示し、「次の画像は 良品か 不良品か 判断しなさい」と 指示します。

- 効果:特定の分野での LLM マルチモーダルの推論能力が飛躍的に向上します。

GEO対策:グローバル展開を見据えた多言語対応

LLM マルチモーダルの GEO(地域最適化)対策 は、多言語の画像認識とローカライゼーションが 中心です。

- 多言語テキスト認識:画像内の文字をOCRで認識する際、その言語を正確に特定し、正しくLLMに入力する処理。例えば、日本語の看板と英語のマニュアルの両方を含む画像を適切に処理できる能力。

- 文化的コンテキストの理解:特定の地域や文化に固有の画像や記号を正しく解釈し、不適切な回答や表現を避けるようモデルを調整します。

まとめ:LLM マルチモーダルが拓くAIの未来と次の行動

要点:LLM マルチモーダルは、AIが人間のように世界を認識し、行動する時代の「基盤」です。

- GPT-4V

- Gemini、Llama 3

などの最新モデルを使って、知識の習得から業務への応用まで、今すぐ最初の一歩を踏み出しましょう。

LLM マルチモーダルの進化がもたらす変革

LLM マルチモーダル技術の急速な進化は、単なる技術の向上ではなく、社会やビジネスのあり方そのものを変える「変革」です。

- 知識の民主化:専門家にしか読めなかった図表や画像資料もLLMが解説することで、誰でも簡単に理解できるようになります。

- 業務効率化の加速:人手で行っていた目視検査やデータ入力がAIに置き換わり、人間はより創造的な仕事に集中できるようになります。

AI初心者からプロへ:次の行動ステップ

この記事を読んで、LLM マルチモーダルの可能性を感じたあなたが次に取るべき行動は以下の通りです。

- 知識の定着と応用 (教育):GPT-4V や Gemini の API ドキュメントを確認し、実際に画像をインプットして試すことから始めてください。API の使い方は弊サイトの別記事(内部リンク案を参照)で詳しく解説しています。

- 自己学習と実験 (行動):オープンソースのLlama 3 multimodalをローカル環境で動かしてみたり、Hugging Faceのデモを使って様々なマルチモーダルタスクを試してください。

- ビジネスへの提案 (行動):自社の業務の中で、画像や動画の処理が含まれる非効率なプロセスを特定し、LLM マルチモーダルを使った解決策を検討してみましょう。

LLM マルチモーダル は AI の新しい標準となりつつあります。この波に乗るために、今日から学習と実践を開始しましょう。

よくある質問(FAQ):LLM マルチモーダルの疑問を解消

Q1. LLM マルチモーダルは画像認識の技術とどう違うのですか?

A. 画像認識単体との違いと優位性

従来の画像認識技術(例:CNNベースの物体検出)は、「何が写っているか(例:猫)」を主な目的としていました。

一方、LLM マルチモーダル は、「猫」という物体の認識に加えて、「なぜ猫がそこにいるのか」といった背景や文脈、さらには「この猫について面白い物語を作って」という創造的な要求にも回答できる能力を持ちます。

つまり、単なる認識から、理解、推論、生成までを統合した点が決定的な違いです。

Q2. 開発に必要なスキルや環境は何ですか?

A. 開発環境と学習へのステップ

LLMマルチモーダルの開発の最初の段階では、既存のAPIを利用することが最も容易な方法です。

- プログラミング 言語:Pythonが主となります。

- ライブラリ:OpenAIやGoogleの公式SDK(ソフトウェア開発キット)、またはLangChainなどのフレームワークの使い方といった知識が必要です。

- ハードウェア:APIを利用するだけであれば、高性能なGPUは不要です。自前でLlamaなどの大型モデルを訓練(訓練)する場合は、高度なGPUリソースが必要となります。

AI初心者の方は、まずGPT-4VやGeminiの無料API枠を使って試すことから始めるのをおすすめします。

Q3. LLM マルチモーダルを業務に導入する際の最大のリスクは 何です か?

A. データのプライバシーと精度の信頼性

LLM マルチモーダル は、機密性の高い画像や動画データを扱うため、セキュリティとプライバシーのリスクが最大の懸念点です。

- データ流出リスク:クラウドベースのAPIを使う際は、入力データがAIプロバイダーのサーバー側でどのように処理され、保存されるかをプライバシーポリシーで確認する必要があります。機密情報はオンプレミスやローカル実行が最適です。

- 幻覚 (Hallucination)リスク:画像や音声の情報が誤って認識し、事実に反する回答を生成するリスクも存在します。重要な判断に使う場合は、必ず人間による最終確認のプロセスを設ける必要があります。

サイト外リンク(9個)

- OpenAI 公式サイト: https://openai.com/

- Google DeepMind 公式サイト (Gemini 関連): https://deepmind.google/

- Meta AI 公式サイト (Llama 関連): https://ai.meta.com/

- Anthropic 公式サイト (Claude 関連): https://www.anthropic.com/

- Hugging Face 公式サイト (オープンソースモデル): https://huggingface.co/

- ArXiv (AI分野の最新論文): https://arxiv.org/

- Microsoft Azure AI (GPT-4V/Gemini の商用利用): https://azure.microsoft.com/ja-jp/products/ai/

- Ricoh Japan (製造業 LLM 事例): https://jp.ricoh.com/

- LangChain 公式ドキュメント: https://www.langchain.com/