あなたは今、ChatGPTやClaude、GeminiといったLLM(大規模言語モデル)を使っているかもしれません。

しかし、以下のような問題に直面していませんか?

- 「質問しても、いつもような平凡な回答しか返ってこない」

- 「複雑なタスクを依頼すると、途中で間違った推論をしてしまう」

- 「どう書けば、AIの能力を最大限に引き出すのか分からない」

これは、あなたがLLMを使いこなせていないのではなく、AIを意図通りに動かすための「質問の技術」、すなわちプロンプトエンジニアリングの知識が不足しているからです。

プロンプトエンジニアリングとは、単なる「質問」ではありません。

LLMが持っている知識と推論能力を特定の目的に合わせて引き出すための「命令文の設計図」を作成するエンジニアリング的な方法です。

この技術は、AI開発者や研究者だけのものではありません。

AIを日常の業務や学習に活用したいすべての人に必要となる、2025年の最も重要なスキルです。

今回の記事は、AI初心者の方々でも、

- LLMの仕組み

- プロンプトの基礎

- Few-shot LearningやChain-of-Thought (CoT)といった最新の高度な手法

まで、段階的に理解できるように構成されています。

この記事を読むことで、あなたのLLMへの質問は劇的に変化し、期待通りの正確なアウトプットを得る方法がわかるでしょう。

さあ、AIを自分の最高のパートナーに変える旅を始めましょう。

LLMとプロンプトの基礎

要点:プロンプトエンジニアリングは、LLM(大規模言語モデル)から期待する回答や結果を引き出すための質問や指示の設計と最適化のプロセスです。

これは、LLMの能力を最大限に活用し、生成AIの可能性を広げるための鍵となります。

まずは基礎知識を理解しましょう。

大規模言語モデル プロンプトの定義と重要性

プロンプトエンジニアリングとは、LLM(Large Language Model:大量のテキストデータで学習します。

人間の言語を理解し、生成できるAIモデル)に対して、

- タスクの目的

- 役割

- 制約条件

などを与える命令や質問文を作成する方法論(engineering)です。

単なる「質問」と「プロンプト」の違いは、「構造」と「意図」にあります。

- 質問:情報を求める単純な行為。(例:「日本の首都はどこですか?」)

- プロンプト:AIに役割を与え、思考の過程を指示し、特定の形式で応答させる綿密な設計図。(例:「あなたは一流のマーケティング専門家です。以下の新商品について、ターゲットユーザーに響くキャッチコピーを3つ考えて。回答は箇条書き形式で書いて。」)

この設計の質が、AIの生成内容の精度を左右します。

LLMの仕組み:トークンとコンテキストの理解

LLMの応答能力を理解する上で、コンテキスト(文脈)とトークンの概念は欠かせません。

- トークン(Token):LLMが言語を処理するための最小単位です。単語、句読点、日本語のひらがな・カタカナ・漢字の一部がトークンになります。プロンプト入力と回答出力の合計トークン数には上限があり、長すぎるプロンプトは一部が無視されたり、途中で切れてしまったりする可能性があります。プロンプトエンジニアリングは、限られたトークン内で最大限の情報を伝える最適化技術でもあります。(注釈:トークンとは、AIが言語を処理する時に使う基本的な「文字の塊」の単位のことです。)

- コンテキスト(Context):LLMに与えられたすべての入力情報(指示、質問、過去の会話履歴、提供した知識データ)のことです。LLMはこのコンテキストに基づいて回答を生成します。プロンプト設計では、LLMが回答に必要な情報をすべて提供し、曖昧さを避けることが極めて重要です。(注釈:コンテキストとは、AIが現在処理している会話や命令の背景情報全体のことを指します。人間の会話でいう「話の流れ」に近いものです。)

実践的なプロンプトの設計方法と最適化

要点:LLMを使いこなすための基本は、

- 「役割の指定」

- 「具体的な指示」

- 「出力形式の明確化」

の3要素をプロンプトに組み込むことです。

これらの基礎手法を実践することで、LLMの応答精度は飛躍的に向上します。

LLM プロンプト 設計の基本

R-I-OフレームワークによるLLM プロンプト 設計

初心者でも簡単に良いプロンプトを書くための基本的なフレームワークとして、「R-I-O」(Role, Instruction, Output Format)を推奨します。

| 要素 | 意味 | 目的 | サンプル(「ブログ記事の要約」タスク) |

| Role(役割) | AIに専門家としての役割を与える | AIの知識ドメインを限定し、質の高い応答を得る | 「あなたは熟練の編集者です。」 |

| Instruction(指示) | タスクの目的、手順、制約を具体的に説明する | LLMに正確に行動させるための道筋を示す | 「以下の記事を読み、主要な3つのポイントに絞って要約しなさい。」 |

| Output Format(出力形式) | 回答を得たい形式を指定する | LLMの出力を自動処理しやすい構造にする | 「要約は、各ポイントを100文字以内の見出しとその説明文で構成する表形式で出力してください。」 |

プロンプト作成で迷ったら、このR-I-Oの3要素がすべて入っているか確認することが成功への近道です。

これは基本中の基本となる構造で、プロンプトエンジニアリングの基礎を作ります。

プロンプト最適化:精度を高める技術

プロンプト最適化のための基本10のルール

プロンプト最適化は、LLMの応答精度を高める継続的な調整プロセスです。次の10のルールを守ることで、LLMを使って得られる成果は劇的に向上します。

- 具体的な指示: 「要約して」ではなく、「小学生にも分かるように100文字以内で要約して」のように、目的と制約を明確に示す。

- 役割の指定:「あなたは経験豊富なコピーライターです」と言い切る。

- ポジティブな指示:「〜をしないで」ではなく、「〜をしなさい」と前向きに命令する。

- 区切り文字の利用:プロンプトの中でデータや指示が混在する場合、「###」や「—」などの区切り文字を使って明確に区別する。

- Few-shot Learning(後述):タスクの良いサンプルをいくつか提示してから、本番の質問を行う。

- 思考の過程の指示(Chain-of-Thought、後述):「ステップバイステップで考えてから答えて」と指示して、推論能力を向上させる。

- 温度(Temperature)の調整:創造性が必要なタスクでは高く、事実確認や要約では低く(0.1~0.5程度)設定する。(注釈:Temperatureとは、AIの回答のランダム性を制御するパラメーターです。値が高いほど、多様で創造的な回答、低いほど、一貫性のある論理的な回答になります。)

- 制約条件の明確化:「100文字以内」「敬語を使用」など、満たすべき条件をすべて記載する。

- 検証とフィードバックの反復:LLMの応答が期待通りでなかった場合、どこが悪かったのかを具体的に修正指示して、再出力を依頼する。

- 複雑なタスクの分割:一度にすべてを頼まず、「情報収集→分析→要約」のように、複数のステップに分けて指示する。

高度な推論を引き出すテクニック

要点:LLMの推論能力を根本から向上させる技術が、Few-shot LearningとChain-of-Thought (CoT)です。

これらは、タスク実行前に手本や思考過程を提示することで、LLMの性能を最大限に引き出す手法です。

Chain-of-ThoughtとFew-shotの応用

Few-shot Learning:例を示すことでAIを「教育」する

Few-shot Learning(フューショットラーニング)は、LLMに回答を求める前に、タスクの入力と理想の出力のペアを少数(Few)提示する技術です。

これにより、LLMは「自分に期待されている回答の形式と内容」を具体的に理解し、精度の高い応答を生成します。

- Zero-shot Learning:タスクの例を一切示さず、命令文のみで回答を得る方法。

- One-shot Learning:タスクの例を1つだけ示す。

- Few-shot Learning:タスクの例を数個(2~5個程度)示す。

例えば、「ポジティブなレビューを『TRUE』、ネガティブなレビューを『FALSE』に分類せよ」というタスクです。

Few-shotでは、実際のレビューと「TRUE」または「FALSE」のラベルを複数提示します。

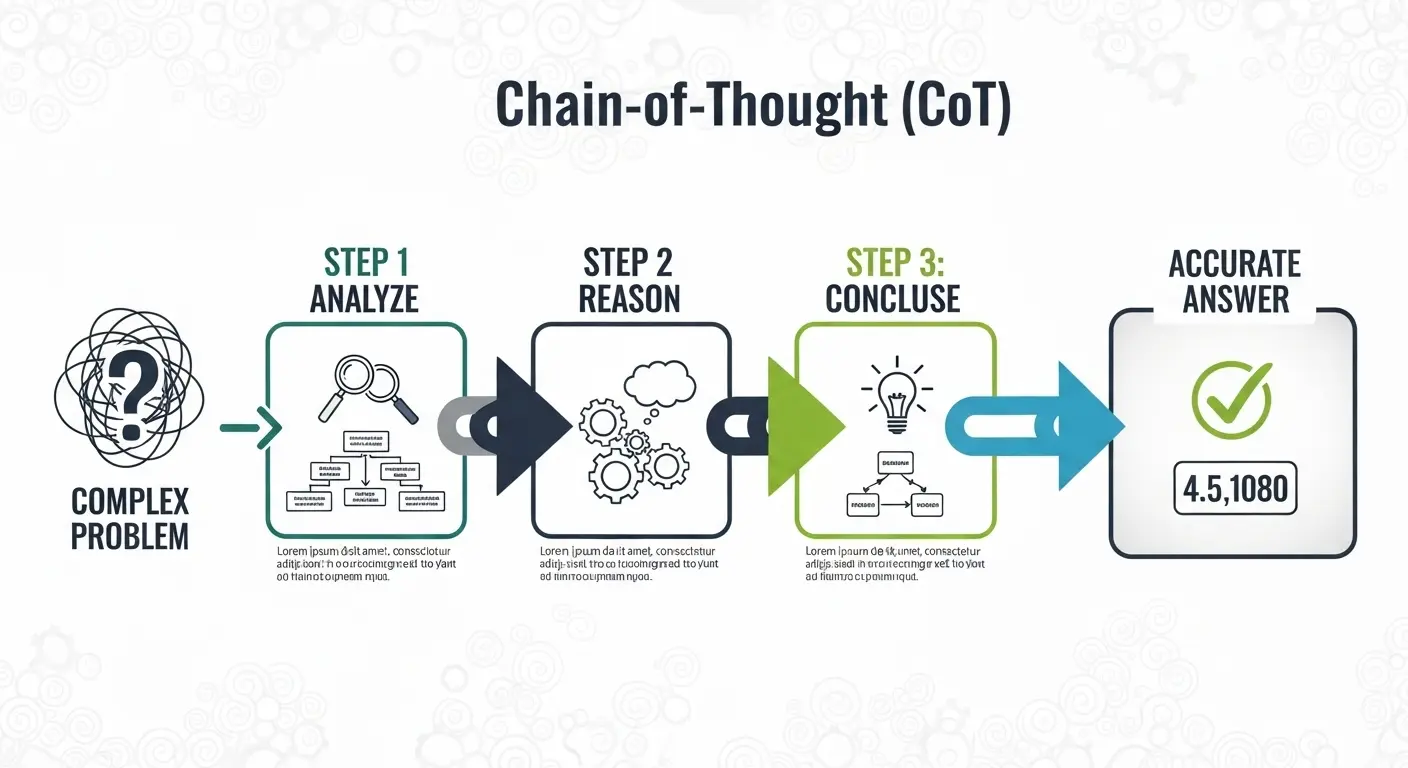

Chain-of-Thought:思考プロセスを「言語化」させる

Chain-of-Thought(CoT:思考の連鎖)は、LLMに最終的な結論を出す前に、人間が問題を解く時の「考える過程」を記述させる手法です。

プロンプトに「ステップバイステップで考えてから結論を述べなさい」と追記するだけで、算術や複雑な推論タスクの精度が劇的に向上します。

- なぜ効果的か:LLMは思考の過程を言語化することで、内部的な推論の誤りを自己修正しやすくなります。これは大規模言語モデルの推論能力を補うために非常に重要なテクニックです。

AIプロンプト テンプレートと実務への活用

要点:プロンプトエンジニアリングの知識は、具体的なテンプレートを活用することで、日常の業務にすぐに活かせます。

特に、役割指定と具体的な出力形式を設定したテンプレートは、業務効率化の鍵です。

AIプロンプト テンプレートの実践

Prompt Engineering ベストプラクティス:RAGの活用

2025年のプロンプトエンジニアリングのベストプラクティスは、LLMの知識の限界を超えることに焦点が当たっています。

その中心にあるのが、RAG(Retrieval-Augmented Generation:検索拡張生成)です。

- RAGとは:LLMが回答を生成する前に、外部の信頼できる情報源(社内ドキュメントや最新のWeb情報)から関連する知識を検索し、その知識をプロンプトのコンテキストに含めて利用する手法です。(注釈:RAGは、AIの回答に関する最新の情報や社内データなど、AIが最初から持っていない知識を与えるための方法です。これにより、ハルシネーション(事実と異なる回答)を避け、回答の信頼性を高めます。)

RAGを使うプロンプトの基本形:

あなたは一流のデータサイエンティストです。

[#CONTEXT]以下の検索結果に基づき、質問に回答してください。

検索結果: [RAGシステムから取得した最新の情報]

[#INSTRUCTION]上記の情報のみに基づき、〇〇について簡潔に説明しなさい。

[#CONSTRAINT]検索結果にない情報は一切追加しないこと。

開発者向けAIプロンプト テンプレート:コーディングとテスト

AIをコーディングの相棒(Copilotなど)にするためには、具体的なタスク設計が重要です。

| 活用例 | 役割(Role) | 具体的な指示(Instruction) | 制約・出力形式(Output Format) |

| Python 関数生成 | あなたは熟練のPython開発者です。 | ユーザーが入力した文字列を反転させる関数(reverse_string)を作成しなさい。 | 出力はコードと解説のみとし、Markdownのコードブロックに限定。 |

| バグ修正と説明 | あなたは厳格なコードレビューアです。 | 以下のコードに含まれる論理的な誤りを見つけ、修正案とその理由を説明しなさい。 | 回答は修正コード、修正点の概要、元のコードの3点を含むJSON 形式で出力。 |

2025年最新LLM動向とエージェント技術

要点:2025年現在、LLMの進化は

- 「マルチモーダル」

- 「高速化」

- 「エージェント」

に焦点が移っています。

最新LLM動向と、外部ツールを自律的に使うAI エージェントを動かすプロンプトの設計を理解することが、最先端の活用に繋がります。

最新LLM動向とAIエージェント

最新LLM動向:GPT-4o、Claude 3.5、Geminiの特性

2025年の主要なLLMは、人間のような応答速度とマルチモーダルの能力を高めています。

これは、プロンプトに対する応答の質だけでなく、AIの利用可能な範囲を広げます。

| モデル | 特性 | プロンプトエンジニアリングの焦点 |

| GPT-4o (OpenAI) | 高速、低コスト、マルチモーダル(音声・画像・テキスト) | 画像や音声など非テキスト入力を考慮したプロンプト設計。特定の出力形式(JSONなど)の精度が高い。 |

| Claude 3.5 Sonnet (Anthropic) | 優れた推論能力、長いコンテキスト対応 | Chain-of-Thought (CoT)を活用し、複雑な問題解決に特化。システムプロンプトの設定が重要。 |

| Gemini 2.5 Pro (Google) | Google サービスとの連携、超長文コンテキスト(100万トークン超) | 長いドキュメントを入力とするRAG システムの構築。プロンプト内の情報の整理と階層化。 |

AI エージェント:複雑なタスクを自律的に実行

プロンプトエンジニアリングの最も新しい形が、AI エージェントの開発です。

AI エージェントとは、LLMを中心に、外部ツール(検索、API、コーディング環境)を使って目的を自律的に達成するシステムのことです。

エージェントのプロンプト設計では、単なる質問ではなく、「最終目的を達成するための行動計画」を立てさせるということが重要です。

- エージェントプロンプトの構造:「# G O A L」(最終目標)「# T O O L S」(利用可能なツール)「# S T E P S」(手順と中間報告の指示)を明示し、LLMを監督者兼実行者とします。

プロンプトエンジニアリングの学習とキャリア

要点:LLMの進化は速いため、知識の更新は欠かせません。

公式ドキュメントや専門書籍を活用し、継続的な学習を行いましょう。

また、プロンプトエンジニアという職種が確立されつつあり、この技術は将来性が非常に高いです。

プロンプトエンジニアリング チュートリアル

LLMを深く学ぶための情報ソースとツール

AI初心者が一歩進んだ知識を得るためには、信頼性の高い情報源を利用する必要があります。

- 公式ドキュメント:OpenAI、Anthropic、Googleの公式ドキュメントは、最新のAPIやモデルの特性を理解するための最良の教科書です。

- サイト外リンク:OpenAI Platform Documentation

- サイト外リンク:Anthropic Claude Documentation

- サイト外リンク:Google AI Gemini Documentation

- 専門書籍: 「プロンプトエンジニアリングの教科書」など、O’Reilly (オライリー)や他の技術出版社から出ている書籍は、体系的に基礎から応用まで学べます。

- コミュニティと論文:Qiita、Zenn、arXiv の論文、GitHub の公開プロジェクトなどを参照し、世界中の開発者の知見を得ることも重要です。

プロンプトエンジニアという新しいキャリア

プロンプトエンジニアリングのスキルは、単なるAIの使い方を超え、新しい職種として確立しつつあります。

- プロンプトエンジニアの役割:企業の課題に対し、LLMの能力を最大限に引き出すための最適なプロンプトやワークフローを設計・実装する専門職。

- 求められるスキル:LLMの理解、PythonやTypeScriptなどを使ったAPI 連携の実装経験、タスクを分解する論理的思考力。

(キャプション: 画像5/7: プロンプトエンジニアの仕事。AIと人間の能力を繋ぐ重要な役割を担います。)

プロンプトの評価と限界への対処方法

要点:プロンプトエンジニアリングは万能ではありません。LLMの限界(ハルシネーションやコンテキストの制限)を理解し、効果的な評価方法(テスト)を導入することが、本番のアプリケーションでの成功に繋がります。

プロンプト最適化の限界と評価

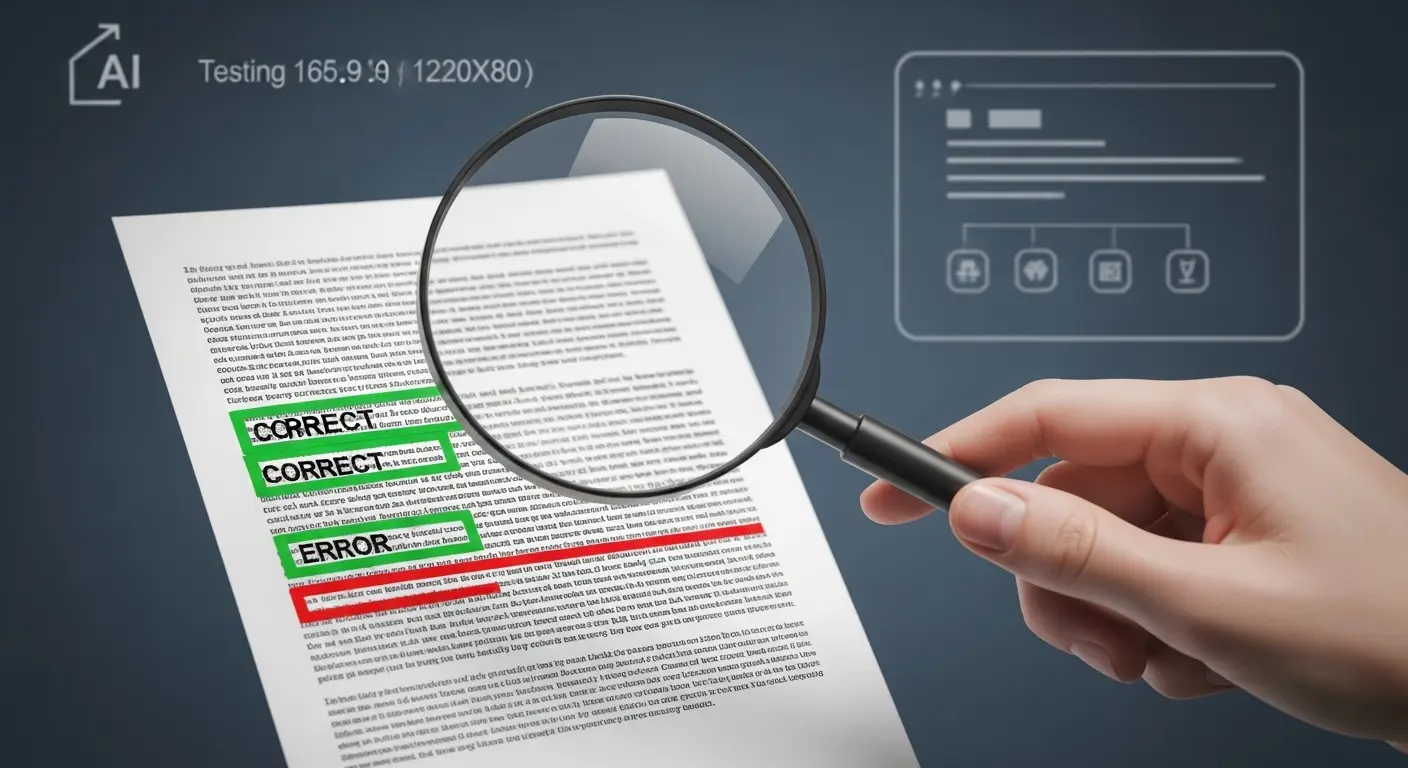

プロンプトの評価方法とテスト

プロンプトが期待通りに機能するかを確認する「評価」は、開発において欠かせないプロセスです。

- 手動評価:最初の段階では、開発者やユーザーが直接回答を読み、精度、倫理的な問題、指示への準拠性を評価する。

- 自動評価:大量のプロンプトをテストする場合、LLMを使ってLLMの回答を評価させる(自動評価)手法や、特定のキーワードの出現率や出力形式の正しさをプログラムでチェックする方法が一般的です。

- 指標:タスクに応じて、回答の

正確性、完全性、関連性などの指標を設定します。

LLMの限界:ハルシネーションとその回避方法

プロンプトエンジニアリングを行っても、LLMは「ハルシネーション」という、事実に基づいていない情報を自信満々に回答する現象を避けることはできません。

- 回避方法:最も有効な回避方法は、RAG (検索拡張生成)を導入し、外部の知識を参照させることです。また、プロンプト内で回答の根拠となるソースの明記を要求することも、有効なテクニックの一つです。

LLM プロンプトエンジニアリング:よくある質問と回答

要点:AI初心者が持つ疑問を解決し、次のステップへの行動を促します。

Chain-of-Thoughtを使う時のプロンプトのコツは何ですか?

CoTを最大限に活かすコツは、「単に考えて」と指示するだけでなく、「どのように考えるか」を具体的に指示することです。

- 良い例:「問題を3つのステップに分解し、各ステップの論理的な推論をまず書いてから、最後に結論を述べなさい。」

- さらに進んだテクニック:「この回答が正しいかどうかを逆に検証する別の視点からも考えてから、最終決定を下しなさい」(自己整合性を促すプロンプト)。

Few-shot Learningで提示する「例」の数はどれくらいが最適ですか?

最適な例の数はタスクの複雑さに依存しますが、一般的に2~5個が効果的です。

- タスクの特性:タスクが単純であれば、1つの例(One-shot)でも十分な場合があります。複雑な推論や微妙なニュアンスの理解が必要なタスクでは、Few-shotがZero-shotより大幅に精度が高まります。

- 注意点:例が多すぎると、コンテキストウィンドウを圧迫し、LLMの「文脈酔い」を引き起こす可能性があるため、5個を目安に、最も効果的な例に絞り込みます。

プロンプトエンジニアリングの知識は今後も必要とされますか?

はい、今後も非常に重要なスキルであり続けます。LLMは進化していますが、根本的な課題は残るからです。

- AI エージェント化:LLMが自律的に動くAI エージェントになるにつれ、「最終目標と制約を明確に示し、行動を制御する」ための高度なプロンプト設計(エージェントプロンプティング)の重要性は増しています。

- カスタマイズと専門性:一般的な質問は簡単になる一方で、企業特有のデータや専門分野に特化した高度なタスクで、LLMの能力を最大限に引き出すプロンプトは不可欠です。

まとめ:LLMの能力を引き出す「質問力」を磨く

要点:プロンプトエンジニアリングは、AIを単なるツールから「強力なパートナー」へと変えるための、2025年最重要のスキルです。

- 基本のR-I-Oと応用のCoT

- Few-shot

を実践し、最新LLM動向とRAGを組み合わせて、あなたの仕事や開発を革新させましょう。

本記事で解説した、LLM プロンプトエンジニアリングの知識と解決策は以下の通りです。

- 知識:プロンプトの定義、トークン・コンテキストの仕組みを理解し、大規模言語モデルの基礎を固めました。

- 解決:R-I-Oフレームワーク、プロンプト最適化の10のルール、Chain-of-Thought、Few-shot Learningの実践的なテクニックを学びました。また、業務に役立つAI プロンプトテンプレートを確認しました。

- 鮮度:GPT-4o、Claude 3.5、Geminiなどの2025年最新LLM動向と、RAGやAI エージェントという未来の技術を学びました。

プロンプトエンジニアリングに「完璧な答え」はありません。試して、フィードバックを得て、修正するという反復的なプロセスが、AIの能力を最大限に引き出すための道です。

今すぐ、あなたの手でプロンプトの設計と最適化を始めてみてください。

サイト外リンク一覧(7個)

- OpenAI Platform Documentation:https://platform.openai.com/docs/

- Anthropic Claude Documentation:https://docs.claude.com/

- Google AI Gemini Documentation:https://ai.google.dev/gemini-api/docs

- GitHub LLM Prompt Engineering ガイド(例):https://github.com/dair-ai/Prompt-Engineering-Guide

- arXiv の CoT 関連 論文 検索 ページ(例):

https://current.ndl.go.jp/car/43217 - O’Reilly (オライリー) の AI 関連 書籍 一覧(例):

https://www.oreilly.co.jp/catalog/ - LangChain 公式 ドキュメント(エージェント 開発 ツール):https://www.langchain.com/