2026年にローカルLLMが注目される理由

要点:2026年現在、openaiのgptシリーズやanthropicのclaudeといったクラウド型aiに対し、プライバシー保護とコスト削減の観点からローカルLLMの導入が企業で急増しています。

2025年から2026年にかけて、nvidiaのblackwell世代(※1)の普及により、個人や自社のサーバーで大規模言語モデル(llm)を実行するハードルは劇的に下がりました。

特にchatgptなどのサービスでは利用規約(※2)による制限や従量課金の費用が課題となっていました。

しかし、オープンソース(※3)の進化により、オフラインでも高性能な生成(※4)が可能です。

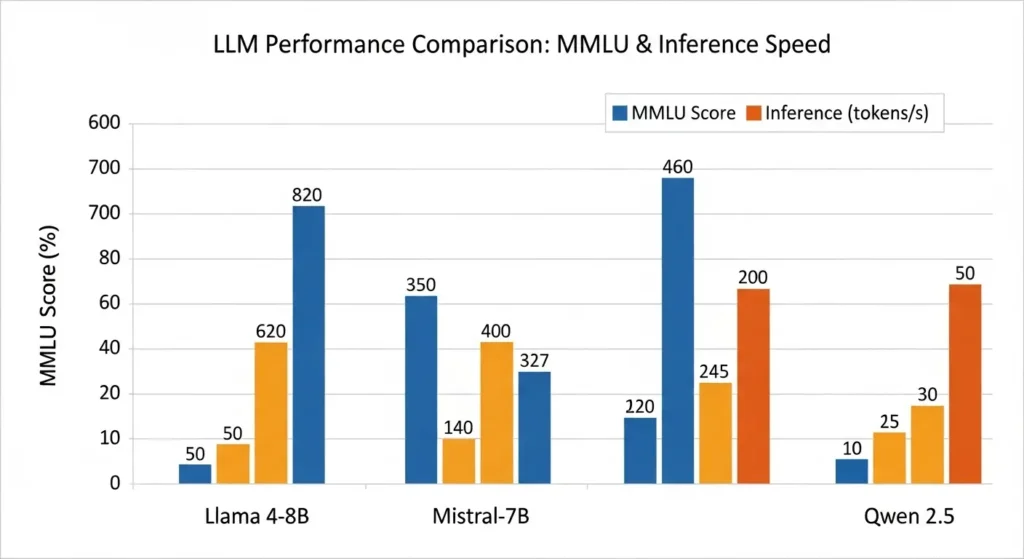

本記事では、最新のローカルLLM ベンチマーク 2026を軸に、モデルごとの推論速度や精度を比較します。

初心者からエンジニアまでが納得できる選び方を解説します。

- ※1 Blackwell:NVIDIAの最新GPUアーキテクチャ。AI処理能力が飛躍的に向上した。

- ※2 利用規約:クラウドサービスでは入力データが学習に利用される可能性がある。

- ※3 オープンソース:設計図が公開されており、誰でも無料で改変・利用できるソフトウェア。

- ※4 生成:AIが文章や画像、コードなどを新しく作り出すこと。

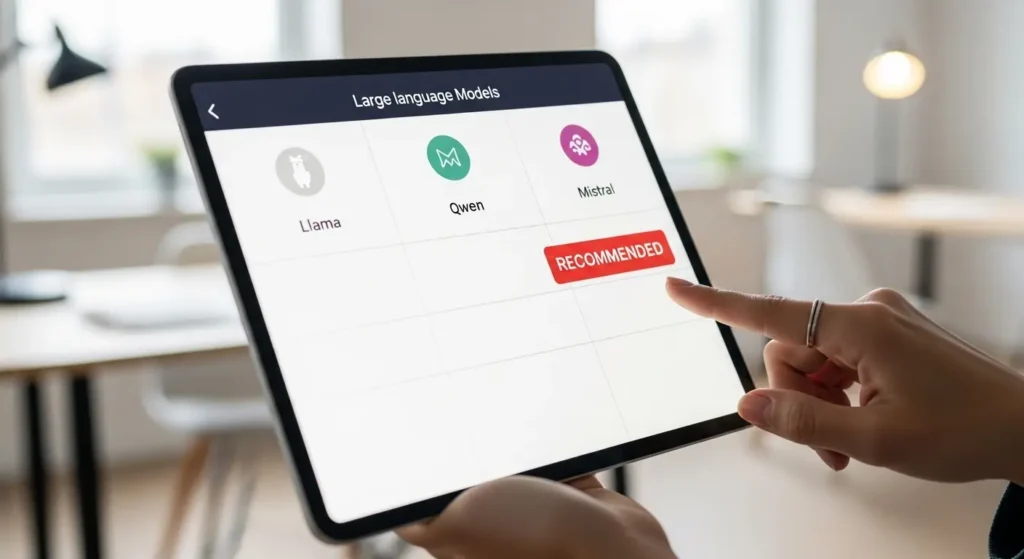

ローカルLLMベンチマーク2026:主要モデル比較

要点:Llama 4やDeepSeek-V3といった最新モデルは、日本語の理解力や論理的思考において、従来のクラウド型aiに匹敵するスコアを記録しています。

オープンソースLLM比較2026

2026年の市場で注目を集めているオープンソースモデルを、用途別に評価しました。

| モデル名 | パラメータ数 | 特徴 | 最適な用途 |

| Llama 4 (8B/70B) | 80億〜700億 | meta(※5)製の最高峰。汎用性が極めて高い。 | 総合的な事務・要約 |

| DeepSeek-V3 | 6710億(MoE) | 数学やコーディングに圧倒的に強い。 | プログラミング支援 |

| Qwen 2.5 / 3 | 7B〜72B | 日本語のニュアンス理解が実用レベル。 | 日本語チャット・翻訳 |

| Mistral Next | 12B | 推論速度が爆速でエッジ(※6)向き。 | リアルタイム応答 |

これらのモデルは、ollamaやlm studio(※7)といったツールを使って簡単にダウンロードし、手元のpcで始めることが可能です。

- ※5 Meta:旧Facebook社。Llamaシリーズを開発・公開し、業界をリードしている。

- ※6 エッジ:スマホやPCなど、クラウドに繋がず手元のデバイスで処理を行うこと。

- ※7 LM Studio:GUIで直感的にローカルLLMを管理・実行できるソフトウェア。

LLMハードウェア要件2026:VRAMが命

要点:2026年のローカルLLMを快適に動かすためには、gpuのvram容量が最も重要であり、最低でも12GB以上が推奨されます。

ローカルでaiを動かす際の最大のハードルは、メモリの不足です。

80億(8B)パラメータのモデルを4ビット量子化(※8)して動かす場合、8gbのvramで足りるケースが多いです。

精度を重視した16gbや24gbのvramを持つgpuがあれば、より大規模なモデルを高速に処理できます。

おすすめハードウェア構成

- エントリー: rtx4060ti (16GB) – 低コストで12〜14Bモデルまで対応。

- ミドル: rtx5070ti (24GB) – 2026年のメインストリーム。32Bモデルもサクサク。

- ハイエンド: rtx 5090 (32GB) – 70Bモデルを実用レベルで駆動。

- Mac環境: m3 max / m4 ultra – unified memory(※9)を128gb以上に増設。

cpuでの推論も可能ですが、gpuと比較すると応答速度は10分の1以下になるため、実務での利用にはグラフィックボードの搭載が必須と言えます。

- ※8 量子化:モデルのデータサイズを圧縮する技術。メモリ消費を劇的に抑えられる。

- ※9 Unified Memory:CPUとGPUでメモリを共有するApple独自の高速な仕組み。

LLM推論速度比較:量子化とエンジンの影響

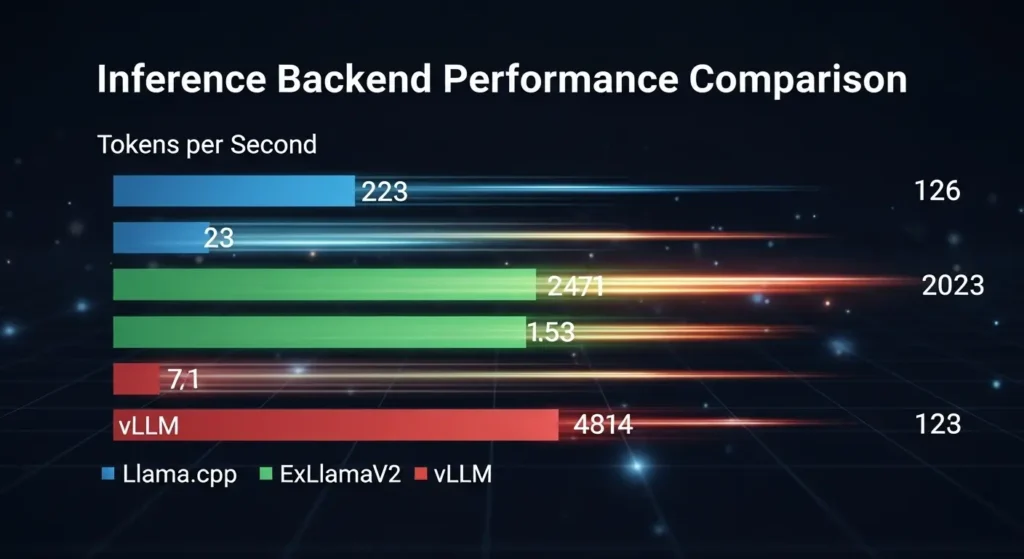

要点:推論速度はハードウェアだけでなく、llama.cppやvLLMといった推論エンジンの選択によっても大きく変化します。

2026年の最新情報では、tensorrt-llm(※10)を利用した最適化が圧倒的なシェアを誇ります。

自社の開発環境で大量のリクエストを処理する場合、単なる導入だけでなくチューニング(※11)が効率を左右します。

推論速度を高めるポイント

- 量子化形式の選択: gguf(※12)よりもexl2の方がgpuでの処理は高速です。

- コンテキストサイズ: 一度に入力する情報(トークン数)を最小限に抑えることで、遅延を低減できます。

- バッチ処理: 複数の問い合わせを同時に行う際の並列化。

ollama(※13)は初心者向けに設定が自動化されていますが、高度なパフォーマンスを求めるユーザーはdocker(※14)上でvllmを構築するアプローチが有力です。

- ※10 TensorRT-LLM:NVIDIAが提供する、GPUでのAI推論を爆速にするライブラリ。

- ※11 チューニング:ハードやソフトの設定を微調整して、性能を最大限に引き出すこと。

- ※12 GGUF:CPU/GPU両方で使いやすく、現在最も普及しているモデル形式。

- ※13 Ollama:MacやWindowsで手軽にローカルLLMを動かせるツール。

- ※14 Docker:アプリを隔離された環境(コンテナ)で安定して動かすための技術。

LLMファインチューニング:ローカルで自分専用AIを作る

要点:2026年の技術では、LoRAやQLoRAといった効率的な手法により、一般的なgpuでも大規模なモデルの追加学習が可能になりました。

1. なぜRAGではなくファインチューニングなのか

2026年のAI運用において、外部知識を参照するRAG(※1)は手軽ですが、AIの「話し方」や「専門的な推論の癖」まで変えることはできません。

ファインチューニングを行うことで、

- 自社独自の専門用語の正確な理解

- 特定の出力形式(JSONなど)の徹底

さらには企業のブランドトーンに合わせた応答が可能になります。

2. 2026年の主流手法:QLoRAとDoRA

現在、個人環境で最も推奨されるのはQLoRA(※49)です。

これはモデルを4ビットに量子化(※2)したまま学習させる手法です。

24GBのVRAMがあれば、Llama 3.3 (70B) 級の巨大なモデルでも一部のパラメータを調整するPEFT(※50)によって学習可能です。

また、最新のDoRA(※51)は学習の安定性が高く、より少ないステップで高品質なモデルが完成します。

3. 学習データ(JSONL)の作成とクレンジング

成功の鍵は「データの量」より「データの質」です。ファインチューニングには、質問と回答のペアをまとめたJSONL形式のデータが必要です。

2026年は、GPT-4oやClaude 3.5 Sonnetなどの強力なクラウドAIを使って、手元の未整理な資料から学習用データを自動生成(シンセティックデータ作成)します。

それをローカルで学習させるハイブリッド手法がトレンドです。

4. おすすめツール:UnslothとAxolotl

- Unsloth: 2026年時点で最も高速な学習ライブラリ。従来のPyTorch(※52)実装に比べ、速度が2倍、メモリ消費が40%削減されています。RTX 4060 Ti (16GB) などのミドルレンジカードでもLlama 3 (8B) の学習が爆速で完了します。

- Axolotl: 設定ファイル(YAML)を記述するだけで、複雑なプログラミングなしに高度な学習設定が可能なエンジニア向けのツール。Docker(※5)環境との親和性が高く、社内サーバーでの運用に最適です。

ファインチューニングのメリットと手法

生成aiをビジネスで活用する際、一般的な回答ではなく自社の製品仕様や過去の対応履歴に基づいた出力が求められます。

これらを実現するための主要なアプローチがファインチューニング(※15)です。

- LoRA / QLoRA: モデルのすべてのパラメータ(※16)を調整するのではなく、一部の重みだけを学習せる手法。vramの消費を劇的に抑え、16GB程度のgpuでも実践できます。

- フルファインチューニング: すべてのパラメータを書き換える手法。精度は高いですが、大量の計算リソースと時間が必要です。

- 継続事前学習: 特定の領域(医療、金融、法律など)の専門用語を大量に読み込ませ、基礎能力を底上げします。

2026年には、axolotlやunsloth(※17)といったオープンソースツールが進化します。

プログラミングの深い知識がなくても、設定ファイルを編集するだけで学習を開始できる環境が整っています。

- ※15 ファインチューニング:学習済みモデルを特定のデータで追加学習させ、目的のタスクに最適化すること。

- ※16 パラメータ:AIの知能を構成する数値の集まり。数が多いほど複雑な表現ができる。

- ※17 Unsloth:学習速度を数倍に高め、メモリ消費を大幅に削減する最新の学習ライブラリ。

- ※49 QLoRA:メモリ消費を極限まで抑えた、効率的な追加学習手法。

- ※50 PEFT:モデルの一部だけを更新する「パラメータ効率的ファインチューニング」の総称。

- ※51 DoRA:LoRAをさらに改良し、学習の精度と速度を両立させた最新技術。

- ※52 PyTorch:AIの開発や学習に世界中で使われている、標準的なフレームワーク。

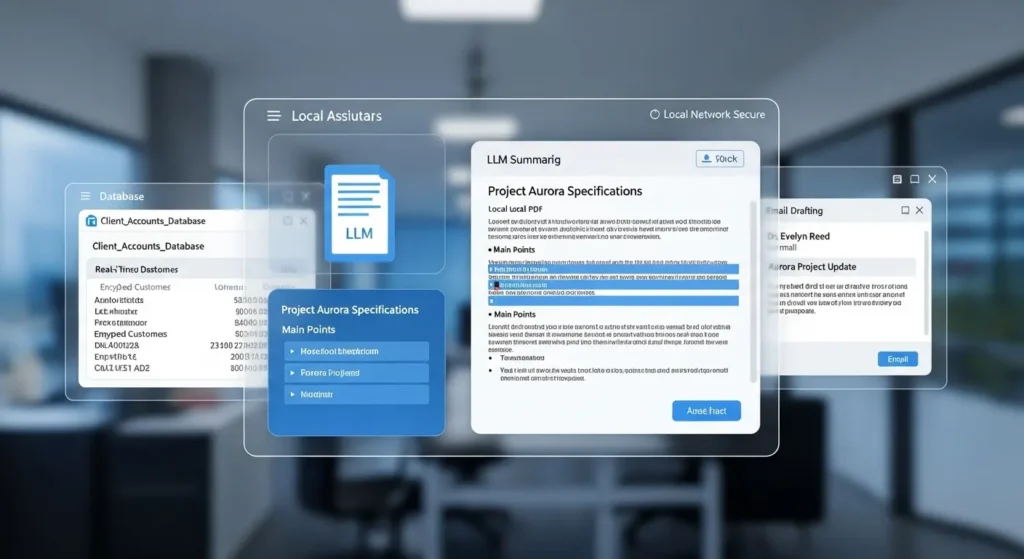

ローカルLLMのセキュリティ対策と運用

要点:ローカルLLMの最大の魅力はセキュリティですが、構築後のネットワーク管理やアクセス制限を適切に行わなければ、リスクはゼロになりません。

情報漏洩を防ぐ完全オフライン運用

企業が自社の機密情報を入力する際、インターネットに接続されたサービスではデータが外部に送信される不安が拭えません。

ローカルLLMを導入すれば、物理的にネットを遮断した環境(エアギャップ(※18))での対話が可能です。

運用時の注意点:

- モデルの信頼性: hugging face(※19)からダウンロードする際は、公式の提供元であることを確認し、悪意のあるコードが含まれていないかチェックします。

- ログイン管理: 社内の複数ユーザーが利用する場合、誰がいつどのような問い合わせをしたかの履歴(ログ)を記録し、監査できる体制を作ります。

- 脆弱性アップデート: 推論用ソフトウェア(ollamaやtext-generation-webuiなど)の最新版を常に追いかけ、脆弱性(※20)への対策を怠らないようにします。

2026年のトレンドは、rag(※21)とローカルLLMを組み合わせます。

検索エンジンのように社内資料を活用しつつ、データは一切外に出さないプライベートaiアシスタントの構築です。

- ※18 エアギャップ:コンピュータをネットワークから物理的に切り離し、外部からの攻撃や漏洩を防ぐこと。

- ※19 Hugging Face:世界中のAIモデルやデータセットが集まる、AI開発のハブとなるプラットフォーム。

- ※20 脆弱性:プログラムの不具合や欠陥。悪用されると情報の改ざんや漏洩に繋がる。

- ※21 RAG(検索拡張生成):外部の文書を検索し、その内容を元にAIが回答を生成する技術。

2026年のAIエージェント:自律するローカルLLM

要点:最新のOllamaやDifyのアップデートにより、ローカルで動作するモデルにブラウザ検索やファイル操作の権限を与え、複雑なワークフローを完結させることが可能です。

ローカルLLMが自律的に働く仕組み

2026年の最新トレンドは、LLMに推論(※22)だけでなく実行(Tool Use)の能力を持たせることです。

Llama 4やDeepSeek-R1といった高性能なオープンソースモデルは、システムプロンプト(※23)を通じて「いつ、どのツールを使うべきか」を判断できます。

具体的な活用事例:

- コールセンター履歴解析: 膨大な音声ログのテキストをローカルで一括要約します。改善案を提示。月16時間かかっていた作業をほぼゼロにした企業も存在します。

- 自律型検索システム: インターネット接続を最小限に抑えつつ、必要な時だけブラウザで最新情報を集め、社内資料と組み合わせてレポートを作成。

- ローカルファイル管理: pc内のドキュメントを自動で分類します。タグ付けやアーカイブ(※24)を行います。

これらの作業はすべてオフラインに近い環境で実行されるため、個人情報や顧客リストを扱う仕事でも安心してaiアシスタントを導入できるのが最大のメリットです。

- ※22 推論:AIが与えられた情報から結論を導き出すプロセス。

- ※23 システムプロンプト:AIの役割やルールをあらかじめ規定する命令文。

- ※24 アーカイブ:重要な記録を保存用の場所に移し、長期的に保管すること。

2026年の主流:エージェント型ワークフロー

従来のAIは一問一答形式でしたが、2026年のトレンドは「計画、実行、検証、修正」をAI自身が繰り返すエージェント型ワークフロー(※53)です。

ローカルLLMが「ブラウザで最新の市場価格を調べて、社内の在庫データと照合します。

発注書を下書きする」といった複数のステップを自律的に判断して進めます。

2. マルチエージェントシステムの普及

社内の複雑な課題を解決するために、得意分野の異なる複数のAIを戦わせるマルチエージェント(※54)手法が一般化しています。

「ライターAI」が書いた文章を「校閲AI」が修正します。

「法務チェックAI」が社内規定との整合性を確認する。

といったチームプレイがローカル環境でも完結します。

これにより、人間は最終的な承認を行うだけで、生産性は飛躍的に向上します。

3. 2026年の注目活用事例

- 製造業:リアルタイム異常検知: ネット接続のない工場内で、ローカルLLMがセンサーデータを監視し、故障の予兆を検知して自動でメンテナンス担当者に通知を出します。

- 法務・金融:機密文書の自動監査: 外部に漏らせない契約書や財務資料をローカルで解析。数万時間かかっていた手作業によるチェックを、セキュリティを維持したまま数分に短縮します。

- マーケティング:自律型リード育成: 自社サイトの対話ログから顧客の悩みを分析します。最適な提案資料を自動作成。SFA(営業支援システム)との連携までをAIが担います。

4. 信頼性とガバナンスの確保

自律性が高まる一方で、AIが勝手に判断を下すことへの懸念も生まれます。

2026年は「Autonomy with Control(管理された自律)」が重要視されています。

Dify(※15)などのプラットフォームで、AIが実行可能な範囲(APIの呼び出しやファイルの書き換えなど)に明確な制限を設けます。

人間が常に監視できる体制を整えることが成功の鍵となります。

- ※53 エージェント型ワークフロー:AIが目標達成のために、自分で手順を計画して実行する一連の流れ。

- ※54 マルチエージェント:複数の専門化されたAIが協力し、単一のAIでは困難なタスクを分担して解決する仕組み。

2026年最新 ローカルLLM 比較 と 賢い 選び方

要点:2025年から2026年にかけて進化したllamaやmistralなどのモデルを比較する際は、単なるベンチマークの数値だけでなく、実際の業務での使い勝手やサポート体制、初期投資の効率を重視すべきです。

1. 用途に応じたモデル選定のポイント

ローカルLLMの選び方で失敗しないためには、まず目次を作るように業務の課題を整理します。

どのカテゴリーのタスクをaiに任せるかを明確にすることが大切です。

- 文章作成

- コンテンツ生成

上記なら自然な対話に優れたモデル。

社内のナレッジ検索なら長文の処理に特化したモデルといった使い分けが効果的です。

googleが提供するgemmaやnvidiaの技術を取り入れたモデルなど、選択肢は非常に幅広いです。

しかし、各モデルのライセンス(apache(※2)やmitなど)によって商用利用の範囲が異なります。

必ず利用規約を確認し、法的なリスクを軽減するようにしましょう。

2. ハードウェア構成とコストのバランス

高性能なgpuへの投資は、長期的にはapiの料金を削減し、ランニングコストを抑える大きなメリットをもたらします。

特に2025年12月から2026年1月にかけてリリースされた最新パーツは、電力効率が向上しております。

24時間稼働させる際の電気代負担を軽減できます。

- メモリ 16GB以上: 軽量な8Bモデルの動作には十分ですが、複数のタスクを同時に処理する場合は32gb以上を検討してください。

- ストレージ 1TB SSD: モデルのファイルサイズは増加傾向にあります。一度に大量のモデルを試すためには、余裕ある容量が安心です。

3. 専門家への相談とコミュニティの活用

自社での導入が難しいと感じた場合は、開発実績の豊富なエンジニアや専門家への相談をおすすめします。

また、githubやredditなどのコミュニティには、実際のユーザーによるインタビューや検証レポートが投稿されております。

独自の環境構築における注意点を知るための貴重なソースとなります。

これらの情報を集め、自社の状況に合った最適なアプローチを取ることが、ai導入を成功に導く唯一の方法です。

一度環境を整えれば、外部の広告やサービスの仕様変更に左右されない、自由で強力な自律型aiアシスタントを手に入れることができます。

- ※1 Gemma:Googleが開発した、軽量ながら高性能なオープンソースモデルのシリーズ。

- ※2 Apache License:商用利用や改変が比較的自由に認められている代表的なオープンソースライセンス。

よくある質問と回答 (FAQ)

要点:ローカルLLM比較2026に関して、ユーザーが導入の際に抱きやすい疑問を整理し、解決に向けたヒントを提供します。

Q1. 2026年現在、ローカルLLMはChatGPT(GPT-4o)を超えていますか?

A1. 純粋な汎用性ではクラウドの巨大なモデルが有利な面もあります。

しかし、特定の領域(コーディングや日本語の特定タスク)では、DeepSeek-V3やQwen 3がGPT-4oに匹敵、あるいは凌駕する結果を出しています。

特にプライバシーとカスタマイズの自由度ではローカルが圧倒的です。

Q2. 初心者におすすめの「最初の一歩」は何ですか?

A2. Ollama(※25)のインストールが最も簡単です。

pcにダウンロードしてコマンドを一つ打つだけで、最新のLlamaが動き始めます。

gui(※26)で操作したい場合はLM Studioを選べば、マウス操作だけで完結します。

Q3. RTX 30シリーズ(旧世代)でも2026年のモデルは動きますか?

A3. はい、十分可能です。特に8B(80億パラメータ)前後の軽量モデルであれば、rtx 3060や3070でも4ビット量子化(※8)を活用すれば高速に動作します。

ただし、最新のblackwell世代に比べると、生成速度や消費電力の面で差が出ます。

- ※25 Ollama:複雑な設定なしにローカルLLMを動かせる、現在最も普及しているツール。

- ※26 GUI:グラフィカル・ユーザー・インターフェース。ボタンやアイコンで直感的に操作できる画面。

結論:あなたに最適なローカルLLMはどれ?

要点:2026年の比較から導き出された結論は、用途とハードウェアのバランスを見極めることが、最も賢いai導入の正解であるということです。

本記事のまとめ:

- コストを抑えて始めたい方:Ollama + Llama 4 (8B)。汎用性が高く、一般的なPCでもサクサク動きます。

- プログラミングや開発効率を上げたい方:DeepSeek-V3。コードの精度と論理思考能力が最強クラスです。

- 社内の機密情報を活用したい方:Dify + ローカルLLMによるRAG構築。セキュリティと業務効率化を両立できます。

- 最高のパフォーマンスを求める方:RTX 5090 + Qwen 3 (72B)。ローカル環境の限界を超える体験が待っています。

2026年、aiはクラウドから手元へと主役が移りつつあります。

自分のライフスタイルやビジネスに合った一台を選び、次世代のテクノロジーを最大限に享受してください。